LangChainとは?5つの機能と導入メリットを完全解説!

この記事でわかること

- LangChainの基本と導入メリット

- 主要コンポーネントと開発支援ツールの活用法

- Python実装と業務応用例

ChatGPTやGeminiなどの大規模言語モデルを最大限に活用したいと考えていませんか?

LangChainは、これらのAIモデルの機能を拡張し、外部データとの連携や複雑な処理の自動化を可能にするライブラリです。

本記事では、LangChainの基本概念から5つの主要機能、実践的な導入方法、そして具体的な活用例まで徹底解説します。

AIアプリケーション開発の効率を飛躍的に向上させるLangChainの可能性を、ぜひ体感してください。

目次

LangChainとは?AI開発を効率化するライブラリの基本

※引用:https://www.langchain.com/

LangChainは、ChatGPTなどの大規模言語モデル(LLM)の機能を拡張し、より高度なAIアプリケーション開発を効率化するためのライブラリです。

従来のAI開発では実現が難しかった機能も、LangChainを活用することで簡単に実装できるようになりました。

ビジネスでのAI活用をより柔軟かつ効率的に進めたい方に最適なツールです。

LangChainの定義と大規模言語モデル拡張の目的

LangChainは、大規模言語モデルの機能拡張を効率的に実装するためのオープンソースライブラリです。

一般的な言語モデルでは、プロンプトの文字数制限や学習データの期間制限、外部データ連携の難しさなど、いくつかの制約があります。

LangChainはこれらの制約を解消し、より実用的なAIアプリケーション開発を可能にします。

特に、長文プロンプトの送信や、回答に最新情報を含めること、外部データとの連携など、ビジネスでAIを活用する際に必要となる機能を簡単に追加できる点が大きな特徴です。

これにより、ChatGPTのような汎用AIを特定の業務用途に最適化したアプリケーション開発が容易になります。

Python・JavaScriptで利用可能なフレームワーク構成

LangChainは現在、PythonとJavaScript/TypeScriptの2つのプログラミング言語で利用できます。

Python版ではLangChainに含まれるすべての機能が利用できるため、最も推奨されています。

JavaScript/TypeScript版も提供されていますが、対応機能はPython版と比較するとやや限定的です。

LangChainのライブラリは以下の3つのパッケージで構成されています。

- langchain-core:基本的な表記法(LCEL)に関するパッケージ

- langchain-community:サードパーティのツールやサービスとの統合機能

- langchain:チェーン、エージェント、検索戦略などの主要機能

これらはpip install langchainコマンド一つでまとめてインストールできるため、環境構築も容易です。

従来のAI開発と比較したLangChainの優位性

従来のAI開発では、異なるモデルを組み合わせたり、外部データを連携させたりするためには、多くのコード記述が必要でした。

LangChainを使用することで、これらの作業を大幅に効率化できます。

特に、複数のAIモデルの切り替えが容易になるため、特定のタスクに最適なモデルを選択できます。

また、プロンプト管理の機能により、チーム開発時のプロンプト表記の統一や最適化が容易になります。

さらに、複数のプロンプトを連鎖させる「Chains」機能や、外部データとの連携機能など、高度な機能も簡単に実装できます。

従来は個別に開発する必要があった機能が、LangChainではすでにパッケージ化されているため、開発期間の短縮とコード品質の向上を同時に実現できる点が最大の優位性です。

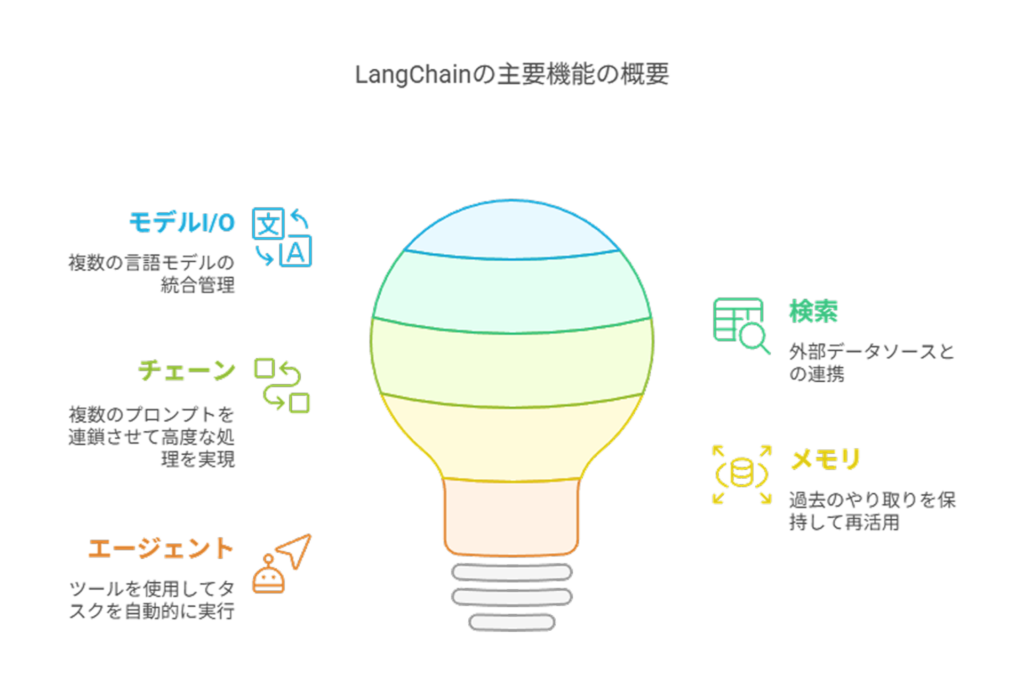

LangChainの5つの主要機能を徹底解説

LangChainには、言語モデルの機能を大幅に拡張するための複数の主要機能が用意されています。

これらの機能を組み合わせることで、単なるチャットボットを超えた高度なAIアプリケーションを構築できます。

ここでは、LangChainの代表的な5つの機能について詳しく解説します。

Model I/O:OpenAIやGeminiなど複数モデルの統合管理

Model I/Oは、様々な言語モデルを統一的に扱うための機能です。

OpenAIのGPTシリーズ、GoogleのGemini、Meta社のLlama、Anthropic社のClaudeなど、多様な大規模言語モデル(LLM)を切り替えたり組み合わせたりすることができます。

この機能により、各モデルの特性に応じた使い分けが可能になります。

たとえば、コスト重視の場合はGPT-3.5を、精度重視の場合はGPT-4を自動的に選択するような設計も可能です。

また、プロンプトのテンプレート化や出力形式の指定なども含まれており、入出力を効率的に管理できます。

- LLMs:質疑応答や文章要約などのタスクを実行する機能

- Chat Model:LLMをチャット形式で使用するための機能

- Embeddings Model:単語や文章をベクトルに変換する機能

Retrieval:PDFやWebなど外部データとの連携機能

Retrievalは、外部データを活用するための機能です。

PDFやExcel、CSV、ウェブページなど、言語モデルが学習していないデータを参照して回答を生成できるようになります。

LangChainのDocument loadersは100種類以上の外部データに対応しており、WebサイトやAWS S3、PDFなど多様なソースからデータを読み込めます。

読み込んだデータは分割・加工し、ベクトル化して保存することで効率的な検索を実現します。

この機能を使えば、最新情報を含めた回答や、社内文書に基づく専門的な回答を生成可能になります。

特に企業の内部データを活用したRAG(Retrieval Augmented Generation)システムの構築に不可欠な機能です。

- Document loaders:多様なソースからのデータ読み込み

- Document transformers:データの分割・加工

- Vector stores:ベクトル化されたデータの管理・保存

- Retrievers:関連性の高いドキュメントの検索

Chains:複数プロンプトを連鎖して高度な処理を実現

Chainsは、複数のプロンプトを連鎖的に実行する機能です。

通常の言語モデルでは、入力に対して1回の回答が生成されるのみですが、Chainsを使うと、AIが生成した回答を次のプロンプトの入力として利用できます。

例えば、長い文章を要約する場合、まず文章を複数のパートに分けて各パートを要約し、次にそれらの要約を統合して全体の要約を作成するといった段階的な処理が可能です。

この方法により、一度では処理しきれない複雑なタスクや、より精度の高い回答が必要なケースに対応できます。

- Simple Chain:最小単位となる基本的なチェーン

- Sequential Chain:複数のチェーンを順番に実行するチェーン

- Custom Chain:特定のケースに対応するためのカスタマイズされたチェーン

Memory機能で実現する”記憶するAIアプリ”

Memory機能は、言語モデルが出力した回答の履歴を保持し、必要に応じて再活用できる機能です。

基本的に、OpenAI社のAPIなどはステートレス(状態を持たない)ですが、Memory機能を使うことで、過去のやり取りを踏まえた自然な会話を実現できます。

Memoryには短期記憶と長期記憶の2種類があります。短期記憶は一つのやり取りの中でデータを保持し、長期記憶は複数のやり取りでデータを保持します。

また、ChatMessageHistoryによってチャットの履歴データを管理し、後からプロンプトを追加することも可能です。

この機能により、ユーザーとの対話の文脈を理解し、より一貫性のある回答を提供できるようになります。

特に顧客サポートや対話型アシスタントの開発において重要な機能です。

Agents|複雑タスクを自動処理するLangChainの真骨頂

Agentsは、LangChainの中でも特に強力な機能で、言語モデルに与えられたツールを用いて自動的にタスクを遂行する機能です。

例えば、情報収集のための検索エンジンとグラフ作成のためのPythonコードなど、複数のツールを組み合わせて活用できます。

Agentsを使うと、言語モデルが自ら「次に何をすべきか」を考え、適切なツールを選択・使用して目標を達成します。

例えば「2000年から2023年までの総理大臣のリストを作成し、その在任期間をグラフ化せよ」という指示に対して、検索機能でデータを集め、Pythonツールでグラフを作成するといった複雑な処理を自動的に行うことができます。

この機能は、複数のステップを要するタスクや、異なるツールを連携させる必要がある複雑な業務フローの自動化に特に有効です。

- Agent:ツールの中から適切な機能を選択・実行する機能

- Tools:外部とやり取りするための機能群(約20種類)

- Toolkits:特定のケース向けにTools初期搭載したAgents

- Agent Executor:Agentsの実行を管理する機能

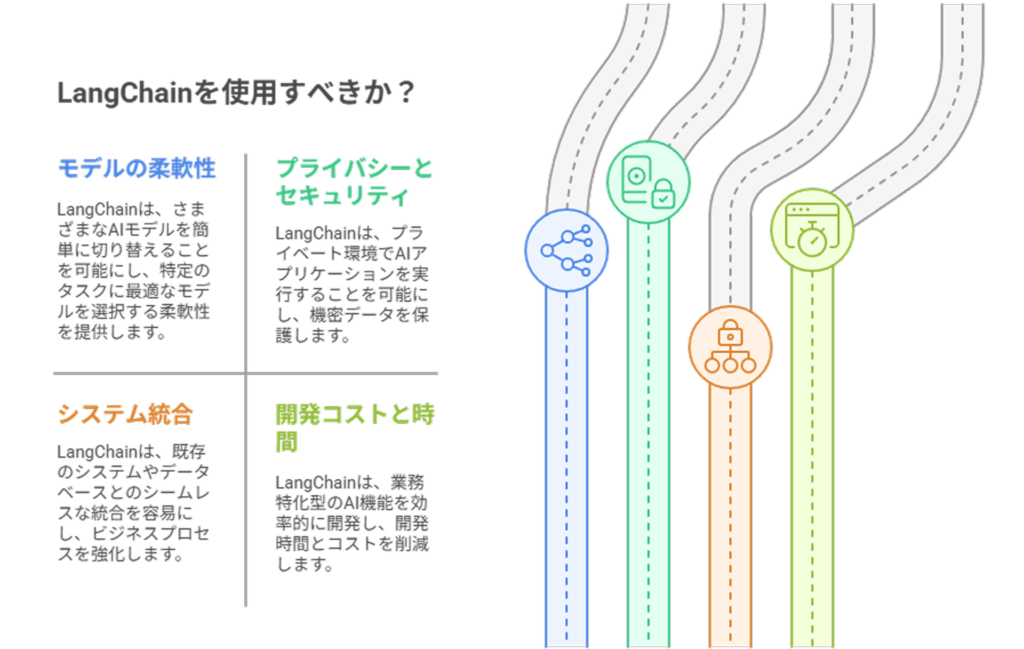

LangChainが解決する4つの開発課題

ChatGPTなどの大規模言語モデルはそのままでは様々な制限があり、ビジネスの現場で活用するにはいくつかの課題があります。

LangChainはこれらの課題を効果的に解決し、より実用的なAIアプリケーション開発を可能にします。

ここでは、LangChainが解決する主要な4つの開発課題について詳しく見ていきましょう。

単一のAIモデルに依存する制限と選択肢の狭さ

ChatGPTの公式サービスを利用する場合、OpenAI社が提供するモデルしか使用できないという制限があります。

これはビジネスにおいて重大な課題となり得ます。

特定のタスクに最適なモデルが別にある場合や、コスト効率、応答速度、精度などの要件によって異なるモデルを使い分けたい場合に柔軟性が不足します。

LangChainを利用することで、OpenAIのGPTシリーズだけでなく、GoogleのGemini、Meta社のLlama、Anthropic社のClaudeなど、多様な大規模言語モデルを簡単に切り替えることが可能になります。

これにより、タスクの性質や予算に合わせて最適なモデルを選択できるようになり、パフォーマンスとコストのバランスを取りながらアプリケーションを開発できます。

プライバシーとセキュリティに配慮した独自環境構築の難しさ

多くの企業では、機密情報や個人情報を外部サービスで処理することに対するセキュリティ上の懸念があります。

公式のChatGPTサービスでは、入力されたデータがOpenAIのサーバーに送信されるため、高いセキュリティ要件を持つ企業では利用が制限されることがあります。

LangChainを使用すれば、社内のプライベート環境でAIアプリケーションを実行できるようになります。

Azure OpenAI Serviceなどのプライベートクラウドサービスと組み合わせることで、データが外部に流出するリスクを最小化しながら、高度なAI機能を活用できます。

これにより、金融、医療、法律などの厳格なセキュリティ要件を持つ業界でも安心してAIを導入できるようになります。

既存システムとAIサービスの連携における複雑性

多くの企業ではすでに様々なシステムやデータベースが稼働しており、これらと新しいAIサービスを連携させることは大きな課題です。

公式のChatGPTサービスでは、既存システムとの統合が限られており、APIを通じた連携も制限されています。

LangChainは既存システムとのシームレスな連携を実現します。

APIやデータベース、社内ドキュメントなど、様々なデータソースと容易に連携できるため、既存のビジネスプロセスを中断することなくAI機能を追加できます。

Retrieval機能を使えば社内のナレッジベースと連携し、Memory機能でユーザー情報や過去のやり取りを保存できるため、より価値の高いアプリケーションを構築できます。

特定業務に最適化したAI機能の開発コストと時間

一般的なChatGPTサービスは汎用的な設計のため、特定の業務に最適化するには追加開発が必要です。

プラグイン機能もありますが、カスタマイズの範囲は限られており、特殊な要件に対応するための開発コストと時間が課題となります。

LangChainを使用すれば、業務特化型のAI機能を効率的に開発できます。

プロンプトのテンプレート化、特定のデータソースとの連携、複雑な処理フローの設計など、多くの機能がすでにパッケージ化されているため、開発期間を大幅に短縮できます。

また、ChainsやAgentsなどの高度な機能を活用することで、最小限のコードで複雑な業務プロセスの自動化が可能になります。

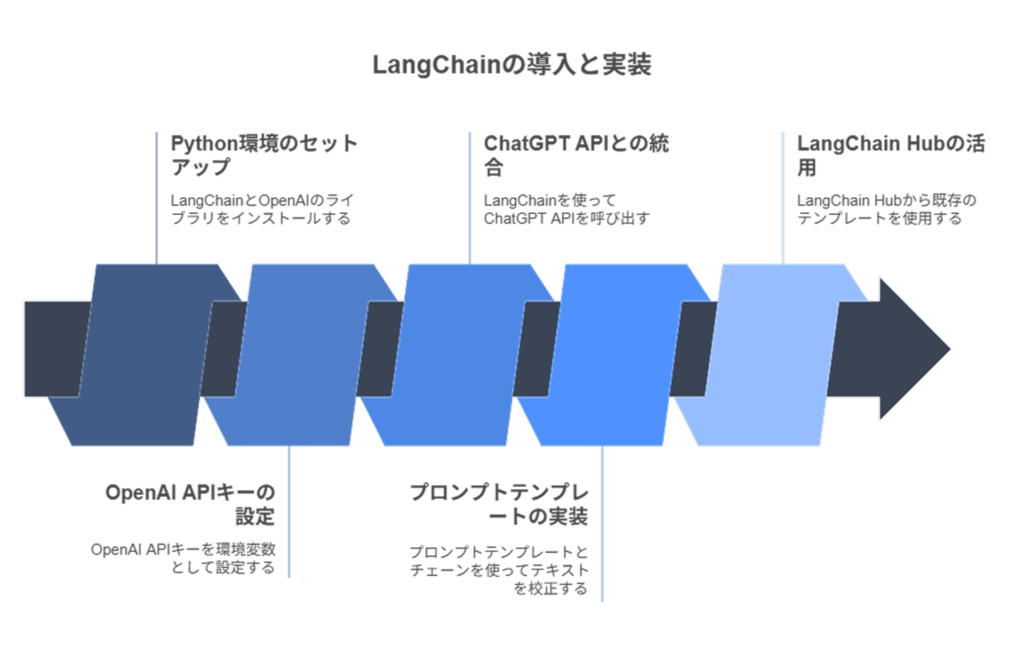

LangChainの導入手順と実装例

LangChainを実際のプロジェクトに導入するための手順と基本的な実装例を紹介します。

Pythonを使った環境構築から実際のコード例まで、段階的に解説していきます。

これらの例を参考に、独自のAIアプリケーション開発を始めてみましょう。

Python環境でのLangChainインストールと基本設定

まずはPython環境にLangChainをインストールします。

コマンドラインから以下のコマンドを実行しましょう。

# LangChainとOpenAIのライブラリをインストール

pip install openai==1.13.3

pip install langchain==0.1.11

pip install langchain-openai==0.0.8

次に、OpenAIのAPIキーを設定します。

APIキーはOpenAIの公式サイトから取得できます。

取得したAPIキーを環境変数として設定しましょう。

import os

# OpenAIのAPIキーを環境変数に設定

os.environ[“OPENAI_API_KEY”] = “あなたのAPIキーをここに入力”

これで基本的な環境構築は完了です。

OpenAIのAPIキーの取得には、OpenAIの公式サイトでアカウント登録が必要です。

アカウント登録後、APIセクションからキーを発行してください。

APIキーは秘密情報なので、公開リポジトリに直接記載しないよう注意しましょう。

ChatGPT APIとLangChainを連携させる方法

OpenAIのChatGPT APIとLangChainを連携させるには、LangChainが提供するラッパーを使用します。

以下のコードで、ChatGPTのモデルをLangChain経由で呼び出せるようになります。

from langchain_openai import ChatOpenAI

# OpenAIのモデルインスタンスを作成

llm = ChatOpenAI(model_name=”gpt-3.5-turbo”, temperature=0)

# モデルを直接呼び出す例

response = llm.invoke(“こんにちは、あなたは誰ですか?”)

print(response)

temperatureパラメータは出力のランダム性を制御します。

0に近いほど決定論的な応答になり、1に近いほど創造的・多様な応答になります。

業務用途では0〜0.3程度の低い値が推奨されます。

また、model_nameでは使用するモデルを指定します。

“gpt-3.5-turbo”はコストパフォーマンスに優れたモデルで、多くのケースで十分な性能を発揮します。

より高度な処理には”gpt-4″などの上位モデルを指定することも可能です。

プロンプトテンプレートとChainsの実装サンプル

実際のアプリケーション開発では、プロンプトテンプレートとチェーンを組み合わせて使用するケースが多いでしょう。

以下に、文章の校正を行うシンプルな例を示します。

from langchain_core.output_parsers import StrOutputParser

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

# OpenAIのモデルインスタンスを作成

llm = ChatOpenAI(model_name=”gpt-3.5-turbo”, temperature=0)

# プロンプトのテンプレート文章を定義

template = “””

次の文章に誤字がないか調べて。

誤字があれば訂正してください。

{sentences_before_check}

“””

# テンプレート文章を設定

prompt = ChatPromptTemplate.from_messages([

(“system”, “あなたは優秀な校正者です。”),

(“user”, template)

])

# 出力解析インスタンスを作成

output_parser = StrOutputParser()

# チェーンを作成 (LCEL形式)

chain = prompt | llm | output_parser

# チェーンを実行

result = chain.invoke({“sentences_before_check”: “こんんんちわ、真純です。”})

print(result)

このコードでは、まずプロンプトテンプレートを定義し、そこにシステムロールとユーザーメッセージを設定しています。

次に、LangChain Expression Language (LCEL) を使って、プロンプト → LLM → 出力パーサーという処理の流れをパイプライン(|)演算子でつなげています。

これにより、コードの可読性が高まり、複雑な処理フローも直感的に記述できます。

LangChain Hubを活用したテンプレート活用術

LangChain Hubは、コミュニティによって作成・共有されたプロンプトテンプレートやチェーンのリポジトリです。

既存のテンプレートを活用することで、開発時間を大幅に短縮できます。

LangChain Hubのテンプレートを使用するには、以下のようにコードを記述します。

from langchain import hub

from langchain_openai import ChatOpenAI

from langchain_core.output_parsers import StrOutputParser

# Hubからプロンプトテンプレートを取得

prompt = hub.pull(“langchain-ai/summarize”)

# モデルとパーサーを設定

llm = ChatOpenAI(model_name=”gpt-3.5-turbo”, temperature=0)

output_parser = StrOutputParser()

# チェーンを構築

chain = prompt | llm | output_parser

# チェーンを実行

result = chain.invoke({“text”: “要約したいテキストをここに入力します。”})

print(result)

LangChain Hubには、要約、翻訳、質問応答など、様々なユースケース向けのテンプレートが用意されています。

自分で一から開発するのではなく、これらの既存リソースを活用することで、開発効率を大幅に向上させることができます。

さらに、自作したテンプレートをHubに公開することも可能です。チーム内での共有や、コミュニティへの貢献にも役立ちますので、積極的に活用してみてください。

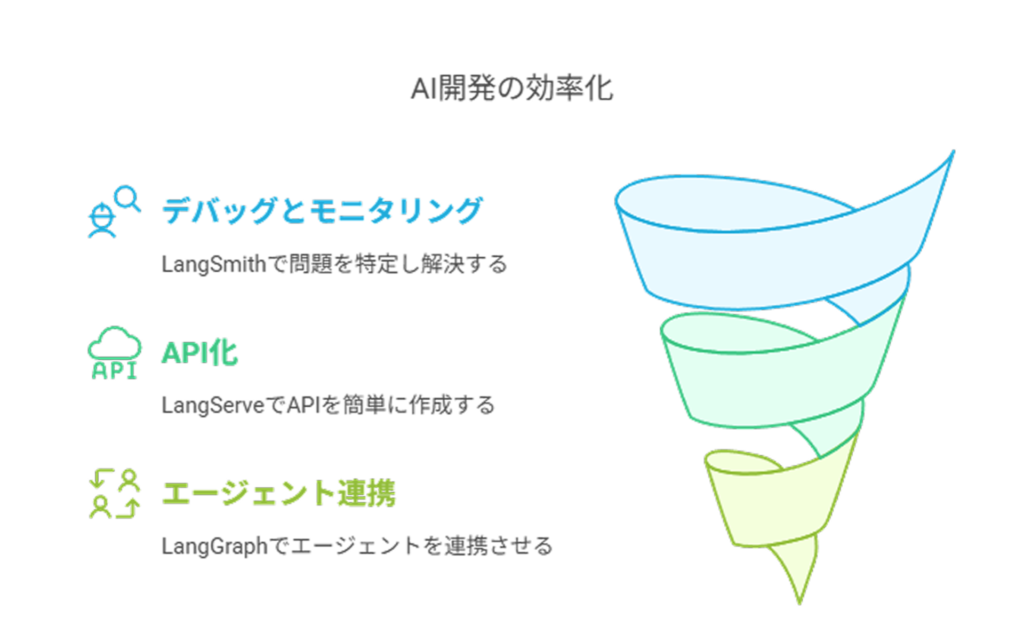

LangSmithとLangServeの活用でLangChainをさらに強化

LangChainは単独でも強力なライブラリですが、周辺ツールであるLangSmith、LangServe、LangGraphと組み合わせることで、さらに開発効率を高め、本番環境への展開をスムーズに行うことができます。

これらのツールはLangChainのエコシステムを形成し、AIアプリケーションの開発・運用をトータルにサポートします。

LangSmithによるデバッグとモニタリングの効率化

LangSmithは、LangChainアプリケーションのデバッグ、テスト、評価、モニタリングを行うための開発者プラットフォームです。

AIアプリケーション開発において最も難しい課題の一つがデバッグと品質管理ですが、LangSmithはこれらの問題を解決します。

具体的には、プロンプトの実行履歴やモデルの応答を可視化し、どの段階で問題が発生しているかを特定できます。

また、異なるプロンプトやモデルのパフォーマンスを比較評価する機能も備えており、最適な構成を見つけるためのA/Bテストも容易に行えます。

本番環境では、リアルタイムのパフォーマンスモニタリングや異常検知も可能で、LLMOps(LLM運用)の基盤として機能します。

LangSmithを導入することで、開発サイクルが大幅に短縮され、より信頼性の高いAIアプリケーションを構築できるようになります。

特に複雑なチェーンやエージェントを開発する際には、欠かせないツールと言えるでしょう。

LangServeを使ったAPI化と簡易デプロイの方法

LangServeは、LangChainで作成したチェーンやエージェントをRESTful APIとして簡単に公開するためのライブラリです。

従来であれば、AIアプリケーションを他のシステムと連携させるためには、WebフレームワークやAPI設計の知識が必要でしたが、LangServeを使えば数行のコードでAPIを構築できます。

from langserve import serve

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

from langchain_openai import ChatOpenAI

# チェーンの作成

template = “あなたは{topic}の専門家です。{question}について回答してください。”

prompt = PromptTemplate.from_template(template)

llm = ChatOpenAI()

chain = LLMChain(llm=llm, prompt=prompt)

# APIとして公開

serve({

“/expert-qa”: chain

})

このシンプルなコードで、エキスパートQAアプリケーションをAPI化できます。

LangServeは内部でFastAPIを使用しているため、自動的にOpenAPI仕様のドキュメントも生成され、APIの利用方法も明確になります。

また、LangChain Templatesと組み合わせることで、定番のユースケースを簡単にデプロイすることも可能です。

LangGraphで実現する複雑なエージェント連携

LangGraphは、複数のエージェントを組み合わせて高度な処理を実現するためのフレームワークです。

単一のエージェントでは解決が難しい複雑なタスクも、異なる役割を持つエージェントを連携させることで効率的に処理できるようになります。

例えば、情報収集、分析、レポート作成をそれぞれ担当する専門エージェントを作成し、それらを連携させることで、より高品質な結果を得ることができます。

また、エージェント間の協調作業を制御するフロー制御機能も備えており、条件分岐や繰り返し処理なども実装可能です。

LangGraphの特徴は、エージェント間のコミュニケーションを視覚化できる点にあります。

複雑なワークフローも図で表現されるため、デバッグや改善が容易になります。

これにより、より高度で複雑なAIシステムを構築する際の障壁が大幅に低減されます。

LangChainを活用した3つの実用例

LangChainの機能を理解したところで、実際のビジネスシーンでどのように活用できるかを見ていきましょう。

ここでは特に効果的な3つの実用例を紹介します。

これらの例を参考に、自社のビジネスにおけるAI活用の可能性を検討してみてください。

専門知識を持つ業界特化型AIアシスタントの開発

一般的なChatGPTでは対応が難しい業界固有の専門知識を持つAIアシスタントをLangChainで開発できます。

医療分野では診断サポートや医学文献検索、金融分野では投資アドバイスや規制対応、法律分野では判例検索や契約書分析など、特定領域に特化したAIアシスタントが実現可能です。

このようなアシスタントを開発する際、LangChainのRetrieval機能が特に重要です。

専門書籍、業界レポート、社内マニュアルなどをベクトルデータベースに格納し、ユーザーの質問に関連する情報を効率的に検索できます。

また、Model I/O機能を使って特定のタスクに最適なモデルを選択することで、精度と応答速度のバランスを最適化できます。

例えば、製薬会社のR&D部門向けに、最新の研究論文と社内研究データを組み合わせた専門AIアシスタントを開発することで、研究者の情報収集効率を大幅に向上させ、新薬開発プロセスを加速することができます。

社内文書に特化したプライベートRAGシステム構築

企業内には膨大な量の文書やナレッジが存在しますが、それらを効率的に検索・活用することは常に課題です。

LangChainを使用して社内文書に特化したプライベートRAG(Retrieval Augmented Generation)システムを構築することで、この課題を解決できます。

このシステムでは、LangChainのDocument loadersを使用して社内の各種文書(マニュアル、議事録、報告書など)を読み込み、Vector storesに格納します。

ユーザーが質問すると、関連性の高い文書を検索し、その情報をもとに回答を生成します。

特に重要なのは、このシステムが社内ネットワーク内で完結できる点です。

Azure OpenAI Serviceと組み合わせることで、機密データがインターネットを通過せずに処理されるため、セキュリティ要件の厳しい企業でも導入可能です。

例えば、大手製造業では、数万ページに及ぶ製品マニュアルや技術仕様書を社内RAGシステムに登録することで、新人エンジニアでも熟練者並みの知識にアクセスでき、トラブルシューティングの時間を大幅に短縮できるようになりました。

複雑な業務フローを自動化する自律エージェント実現

LangChainのAgents機能を活用することで、複数のステップを要する複雑な業務フローを自動化する自律型エージェントを開発できます。

このエージェントは与えられた目標に向けて、適切なツールを選択・使用しながら作業を進めます。

例えば、週次レポート作成の自動化を考えてみましょう。

エージェントはまず社内システムからデータを取得し、Pythonコードを使って分析を行い、その結果を要約してレポートを作成し、最後にメールで関係者に配信するといった一連の流れを自動的に実行できます。

また、顧客問い合わせに対するスケジューリング、データ分析、議事録作成など、複数のツールを連携させる必要がある業務も自動化が可能です。

特に注目すべきは、このエージェントが「次に何をすべきか」を自ら判断できる点です。

単純なワークフロー自動化ツールとは異なり、状況に応じて柔軟に対応できるため、例外ケースや予期せぬ状況にも対処できます。

これにより、単純作業から解放された従業員がより創造的・戦略的な業務に集中できるようになります。

まとめ:LangChainで大規模言語モデルの可能性を広げよう

本記事では、LangChainの基本概念から主要機能、実装方法まで解説してきました。

LangChainを活用することで、複数のAIモデルの切り替え、外部データの連携、複雑な処理フローの構築など、従来は難しかった高度なAIアプリケーション開発が効率化されます。

また、LangSmithでのデバッグやLangServeによるAPI化も容易になり、AIアプリケーション開発の敷居を下げています。

業界特化型AIアシスタント、社内RAGシステム、自律型エージェントなど、ビジネスシーンでの活用方法も多岐にわたります。

AI活用による業務効率化や新サービス創出を目指す企業にとって、LangChainは最適な選択肢となるでしょう。

【生成AI活用でお困りではないですか?】

株式会社アドカルは主に生成AIを活用したマーケティングDXや業務効率化に強みを持った企業です。

貴社のパートナーとして、少数精鋭で担当させていただくので、

「生成AIを業務に活用したい」

「業務効率を改善したい」

「自社の業務に生成AIを取り入れたい」

とお悩みの方は、ぜひ弊社にご相談ください。

貴社のご相談内容に合わせて、最適なご提案をさせていただきます。

サービスの詳細は下記からご確認ください。無料相談も可能です。