生成AIのハルシネーション対策とは?原因や対策、プロンプトを紹介

この記事でわかること

- 生成AIのハルシネーションとは何か

- ハルシネーションが起きる主な原因

- 基本的な対策から応用的な対策まで

- 企業での具体的な対策方法

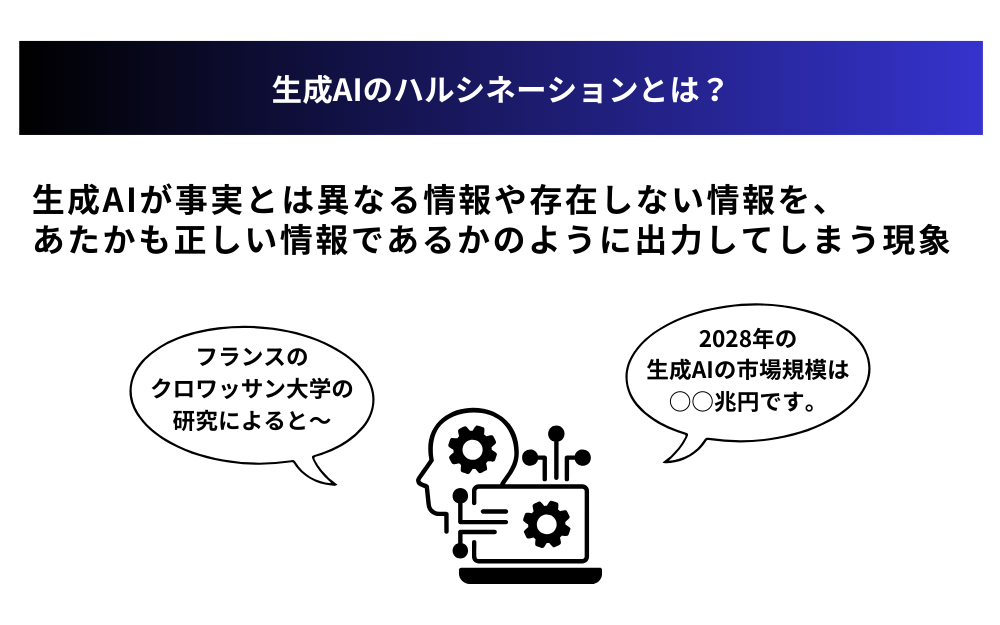

生成AIの活用が広がる中で、避けては通れない課題として注目されているのが「ハルシネーション」です。ハルシネーションとは、生成AIが誤った情報や存在しない情報を出力してしまう現象のことです。

企業での生成AI活用において、このハルシネーションへの適切な対策は必須となっています。しかし、「どのような対策を講じれば良いのか」「発生時にどう対応すべきか」といった具体的な方法については、まだ手探りの企業も多いのではないでしょうか。

本記事では、生成AIのハルシネーションの基本的な知識から、プロンプトを活用した具体的な対策方法、さらには企業での実践的な導入ポイントまで、体系的に解説します。実務で即活用できる方法を、基本編と応用編に分けてご紹介していきます。

目次

生成AIのハルシネーションとは?

生成AIのハルシネーション(Hallucination)とは、生成AIが事実とは異なる情報や存在しない情報を、あたかも正しい情報であるかのように出力してしまう現象を指します。「ハルシネーション」という言葉は、本来「幻覚、幻影」を意味する医学用語ですが、AIが実在しない情報を作り出す様子が人間の幻覚に似ていることから、この用語が使用されるようになりました。¥

ハルシネーションの2つのタイプを理解する

生成AIのハルシネーションは、発生パターンによって2つのタイプに分類されます。

Intrinsic Hallucinations(内在的ハルシネーション)

学習済みデータの内容と矛盾する情報を出力するタイプ

例:日本の首都は「東京」と学習しているにも関わらず、「東京と京都が首都である」と回答する

Extrinsic Hallucinations(外在的ハルシネーション)

学習データに存在しない情報を新たに作り出すタイプ

例:存在しない製品の発売日や仕様について具体的に説明する

なぜハルシネーションは問題なのか

ハルシネーションが重大な問題として認識される理由は、ビジネスや意思決定に深刻な影響を及ぼす可能性があるためです。過去に、アメリカの弁護士が生成AIを使用して準備した法的文書に、実在しない判例が引用されていた事例があります。

ハルシネーションにより、以下のような深刻な問題につながる可能性があります。

- 誤った情報に基づく意思決定による損失

- 企業の信頼性やブランド価値の低下

- 法的リスクや規制違反の可能性

- 顧客や取引先との関係悪化

特に企業での活用において、ハルシネーションは単なる技術的な問題ではなく、ビジネス全体に影響を及ぼすリスク要因として認識する必要があります。そのため、ハルシネーションへの対策は、生成AI導入時の重要な検討事項となっています。

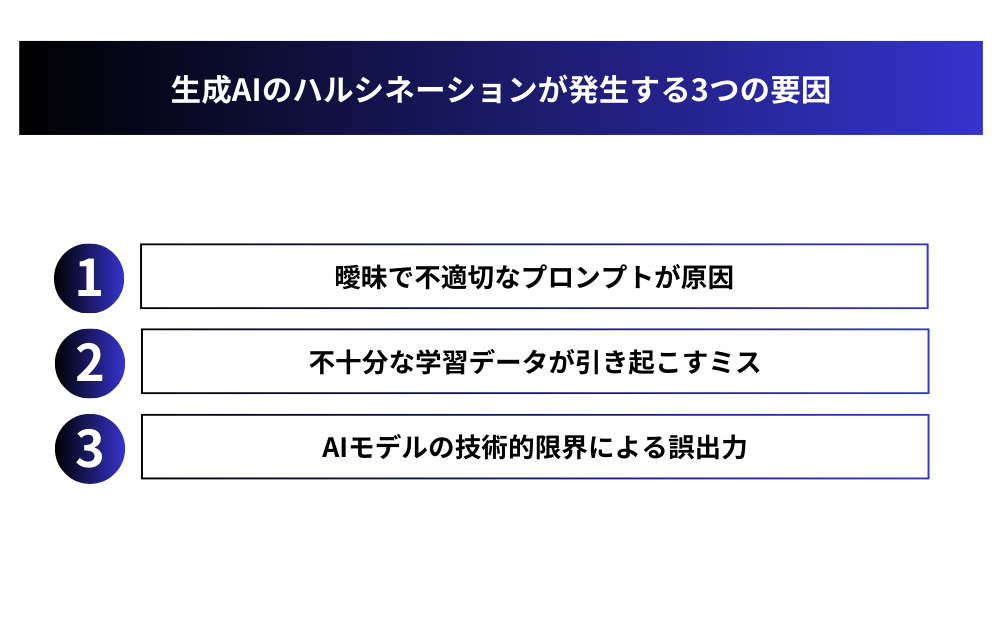

生成AIのハルシネーションが発生する3つの要因

生成AIのハルシネーションは、主に3つの要因によって引き起こされます。これらの要因を理解することは、効果的な対策を講じる上で重要な第一歩となります。

曖昧で不適切なプロンプトが原因

プロンプト(指示文)の質は、生成AIの出力精度に直接的な影響を与えます。特に以下のような問題のあるプロンプトは、ハルシネーションを引き起こす可能性が高くなります。

- 質問の意図や対象が不明確な場合

例:「彼の業績について教えて」(誰の業績かが不明確) - 誘導的な前提を含む質問

例:「宇宙人の存在を証明する最新の研究について」(存在証明の研究があることが前提) - 時期や範囲が曖昧な指示

例:「最近のテクノロジートレンドは?」(「最近」の定義が不明確)

不十分な学習データが引き起こすミス

生成AIの出力精度は、学習データの質と量に大きく依存します。以下のような学習データの問題は、ハルシネーションの直接的な原因となります。

- データ量の不足による認識の偏り

- 古いデータや誤った情報の混在

- 特定分野のデータの欠如

- データの偏りによる一般化の誤り

例えば、特定の分野のデータが不足している場合、AIは限られた知識を基に推測を行い、不正確な情報を生成してしまう可能性があります。

AIモデルの技術的限界による誤出力

現在の生成AI技術には、以下のような本質的な限界が存在します。

- 因果関係の理解の限界

- 文脈理解の不完全さ

- 最新情報の反映制限

- 論理的整合性の維持の難しさ

これらの技術的限界は、モデルの設計や学習方法に起因する根本的な課題であり、完全な解決には更なる技術革新が必要です。現状では、これらの限界を理解した上で、適切な利用方法を選択することが重要です。

生成AIのハルシネーションは、これら3つの要因が単独で、あるいは複合的に作用して発生します。特に実務での活用においては、各要因の特徴を理解し、適切な対策を講じることが不可欠です。

【基本編】生成AIのハルシネーション対策方法4つ|プロンプト例付き

ハルシネーションを完全に防ぐことは困難ですが、以下の基本的な対策を実施することで、その発生リスクを大幅に低減することができます。

「わからない」と言わせる

生成AIに対して、不確かな情報については「わからない」と正直に答えるよう明示的に指示することで、不確実な情報の生成を防ぐことができます。

プロンプト例:

この質問に答える際は、確信が持てない情報については「わかりません」または「確認が必要です」と回答してください。2028年の日本の生成AI市場規模について教えてください。

この方法により、AIは確実な情報のみを提供し、不確かな情報の生成を避けることができます。

直接引用を使用する

AIに対して、回答の中で参照元からの直接引用を含めるよう指示することで、情報の信頼性を高めることができます。

プロンプト例:

添付の文章から重要なポイントを抽出する際は、必ず原文からの直接引用を「」で示してください。引用できない情報は含めないでください。

この手法により、AIの回答と元の情報源との整合性を確認しやすくなります。

引用による検証

生成AIに対して、提供する情報の出典や根拠を明示するよう求めることで、回答の検証可能性を高めることができます。

プロンプト例:

回答には必ず情報源を含めてください。情報源を示せない場合は、その旨を明記してください。生成AIの歴史的な発展について説明してください。

この方法により、後からの事実確認が容易になり、情報の信頼性を担保することができます。

「ハルシネーションをしないで」と指示を出す

生成AIに対して明示的にハルシネーションを避けるよう指示することで、より慎重な回答を引き出すことができます。

プロンプト例:

「ハルシネーションをしないでください。量子コンピューターの現状について説明してください。」

この直接的なアプローチにより、生成AIはより保守的な回答を行い、推測や不確かな情報の生成を控えるようになります。

これらの基本的な対策は、単独でも効果がありますが、複数の方法を組み合わせることで、より高い効果を得ることができます。特に重要な情報を扱う場合は、複数の対策を併用することをお勧めします。

ハルシネーションの対策については、Claudeの公式ブログ「Reduce hallucinations」もご参照ください。

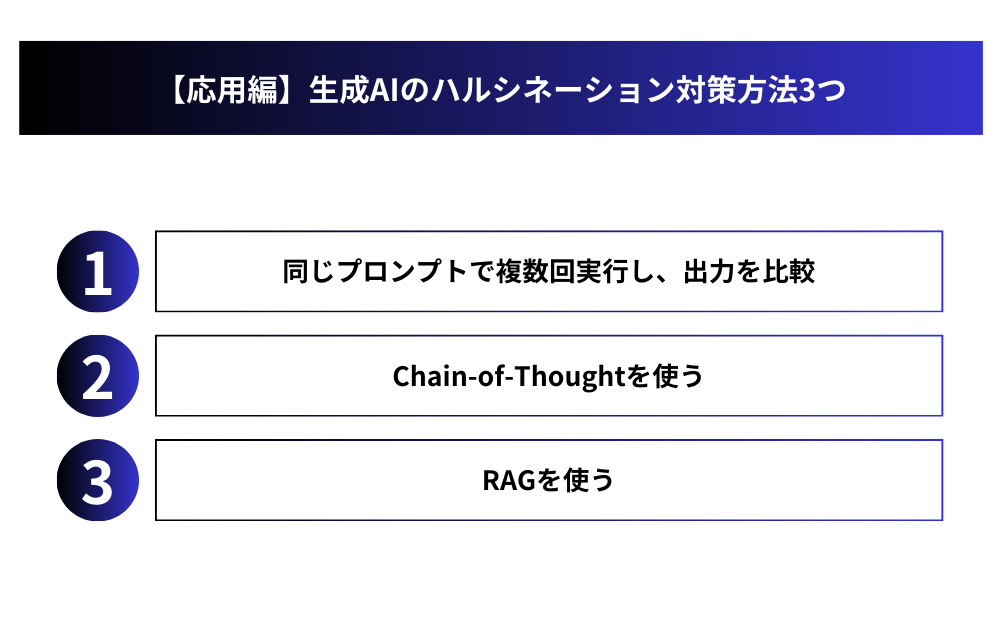

【応用編】生成AIのハルシネーション対策方法3つ

基本的な対策に加えて、より高度な手法を導入することで、ハルシネーションのリスクをさらに低減することができます。ここでは、実務での活用に特に有効な応用的な対策方法を紹介します。

同じプロンプトで複数回実行し、出力を比較

生成AIの出力は確率的な性質を持つため、同じプロンプトでも実行のたびに異なる結果が得られる可能性があります。この特性を活用した対策として、同一のプロンプトを複数回実行し、結果を比較する方法があります。

この手法では、まず同じプロンプトで2回以上の実行を行い、得られた結果の一貫性を確認します。複数の結果で共通して現れる情報は信頼性が高い可能性がありますが、結果が異なる部分については特に注意が必要です。この比較検証により、不安定な出力や潜在的なハルシネーションを検出することができます。

Chain-of-Thoughtを使う

Chain-of-Thought(思考の連鎖)は、生成AIに思考プロセスを段階的に説明させることで、より論理的で検証可能な回答を得る手法です。この方法では、生成AIに最終的な回答だけでなく、そこに至るまでの思考過程も含めて説明させます。各ステップでの判断根拠を明確にすることで、論理の飛躍や不自然な推論を発見しやすくなります。

例えば、ある結論に至るまでの過程を「まず、与えられた情報から…次に、これを考慮すると…したがって…」というように段階的に説明させることで、思考の流れを追跡可能にします。この手法により、ハルシネーションの発生を抑制するとともに、万が一発生した場合でも、どの段階で問題が生じたのかを特定しやすくなります。

Chain-of-Thoughtについては「CoT(Chain-of-Thought)プロンプティングとは?」の記事をご覧ください。

参考論文:『Chain-of-Thought Prompting Elicits Reasoning in Large Language Models』(Googleの公式ブログ記事)

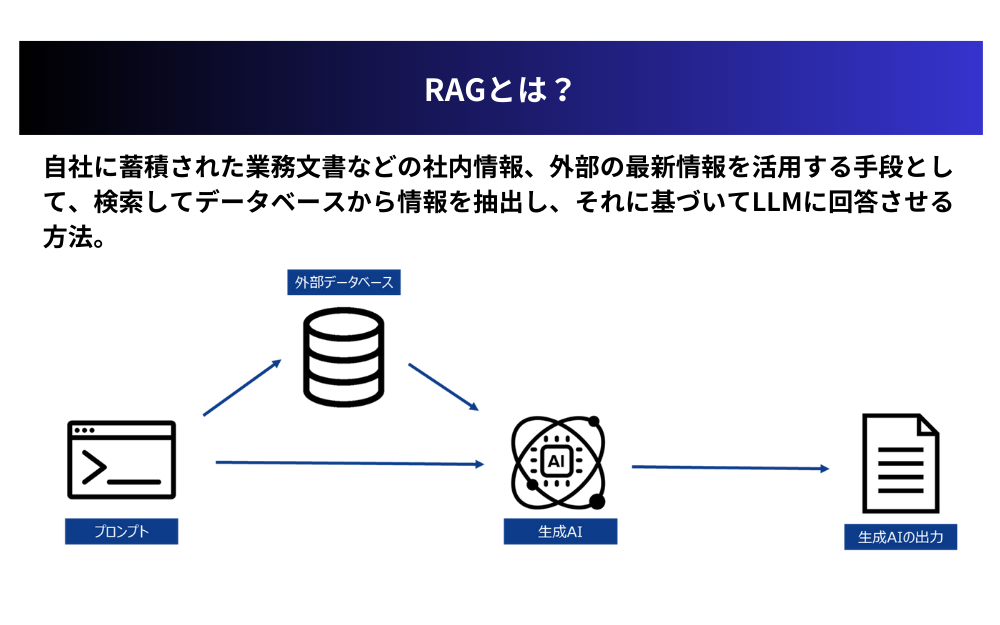

RAGを使う

RAG(Retrieval-Augmented Generation:検索拡張生成)は、信頼できる特定のデータベースや文書群から情報を検索し、その結果に基づいて回答を生成する手法です。この方法の最大の特徴は、AIの回答を予め用意された信頼できる情報源に基づいたものに限定できる点です。

実装においては、まず信頼できる文書やデータをインデックス化し、ユーザーからのクエリに関連する情報を検索します。その後、検索結果に基づいて回答を生成し、使用した情報源を明示します。この手法の主な利点として、情報源が明確で検証可能であること、最新情報への対応が容易であること、そして組織固有の知識を活用できることが挙げられます。

これらの応用的な対策は、実装にある程度の技術的知識や準備が必要となりますが、特に企業での本格的な生成AI活用において、その効果は大きく、投資に見合う価値があります。また、これらの手法は組み合わせて使用することも可能で、より確実なハルシネーション対策として機能させることができます。

RAGについては『RAGとは?仕組みやメリット、活用法、作り方を分かりやすく解説』の記事で詳しく解説しております。

生成AIのハルシネーション対策を行う際の注意点3つ

生成AIのハルシネーション対策を実施する際は、効果的な運用のために以下の3つの重要な注意点を意識する必要があります。

完全な防止は不可能という認識を持つ

現在の技術水準では、ハルシネーションを100%防ぐことは不可能です。これは生成AIの技術的な特性に起因する本質的な課題であり、どれだけ高度な対策を実施しても、完全な防止は困難です。そのため、常にハルシネーションが発生する可能性があることを前提とした運用体制を整える必要があります。特に重要な意思決定や外部向けコンテンツの作成では、必ず人間による最終確認のプロセスを組み込むことが不可欠です。

対策コストと効果のバランスを考える

ハルシネーション対策には、システム導入や運用、人的リソースなど、様々なコストが発生します。例えば、RAGシステムの導入には初期投資と維持費用が必要であり、複数回の実行による検証はAPI利用料の増加につながります。また、人的リソースの面でも、確認作業やシステム運用のための人員配置が必要になります。これらのコストと、業務における重要度や使用頻度を考慮し、適切なレベルの対策を選択することが重要です。

定期的な効果検証と改善が必要

ハルシネーション対策は、一度導入して終わりではありません。生成AIの技術は日々進化しており、新たな課題や対策方法が常に登場しています。そのため、導入した対策の効果を定期的に検証し、必要に応じて改善を行うことが重要です。また、現場での運用実態を把握し、対策が形骸化していないかどうかを確認することも必要です。効果検証の結果は、組織内で共有し、より良い対策方法の検討に活用することで、継続的な改善が可能になります。

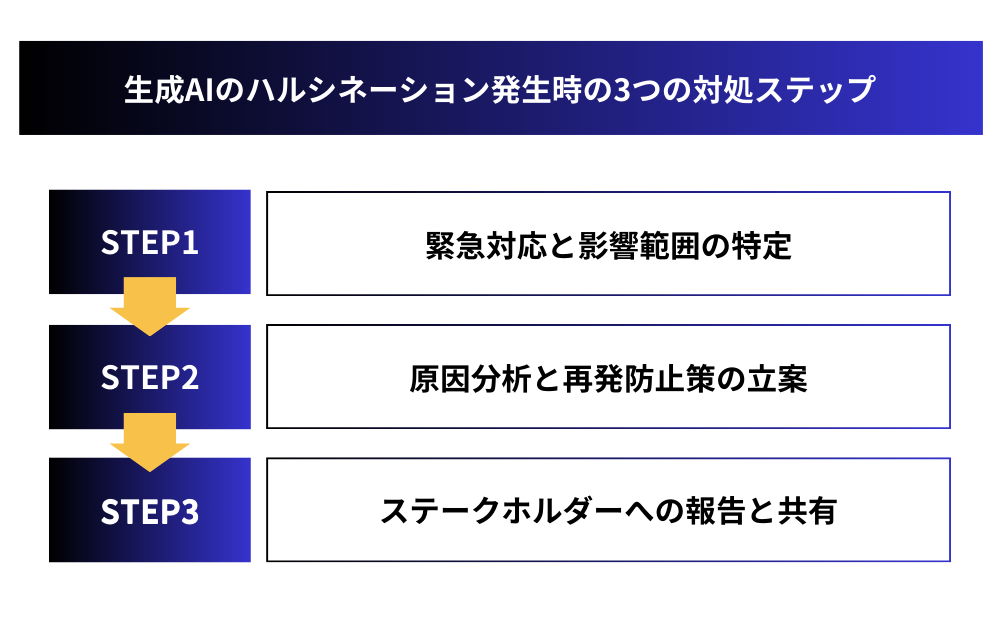

生成AIのハルシネーション発生時の3つの対処ステップ

ハルシネーションが発生した場合、迅速かつ適切な対応が求められます。以下の3つのステップに従って対処することで、影響を最小限に抑え、再発を防ぐことができます。

STEP1:緊急対応と影響範囲の特定

ハルシネーションが発見された場合、まず最初に行うべきは緊急対応です。誤った情報が外部に公開されている場合は、直ちに該当コンテンツの非公開化や訂正を行います。また、その情報を基に既に何らかの意思決定や行動が取られている可能性があるため、影響を受ける可能性のある関係者やプロセスを特定する必要があります。この段階では、発生した事象の記録と時系列の整理も重要です。特に、どのような条件下でハルシネーションが発生したのか、具体的な状況を詳細に記録しておくことが、後の分析に役立ちます。

STEP2:原因分析と再発防止策の立案

緊急対応が完了したら、次は原因分析を行います。プロンプトの内容、使用したモデル、実行時の設定など、あらゆる角度から分析を行い、ハルシネーション発生の要因を特定します。この分析結果に基づいて、具体的な再発防止策を立案します。例えば、プロンプトの見直し、検証プロセスの追加、使用するAIモデルの変更などが考えられます。また、組織的な対策として、チェック体制の強化やガイドラインの改定なども検討します。立案した防止策は、実現可能性と効果を十分に検討した上で、優先順位をつけて実施することが重要です。

STEP3:ステークホルダーへの報告と共有

最後に、発生した事象と対応状況について、関係するステークホルダーへの報告を行います。報告内容には、発生した事象の概要、影響範囲、取られた対策、再発防止策を含めます。特に、経営層や法務部門など、組織の重要な意思決定者には、リスク管理の観点から詳細な報告を行う必要があります。また、この経験を組織の学びとして活かすため、発生した問題と対応策について、関係部門での共有も重要です。可能な範囲で、他のプロジェクトやチームにも知見を展開することで、組織全体のリスク管理能力の向上につながります。

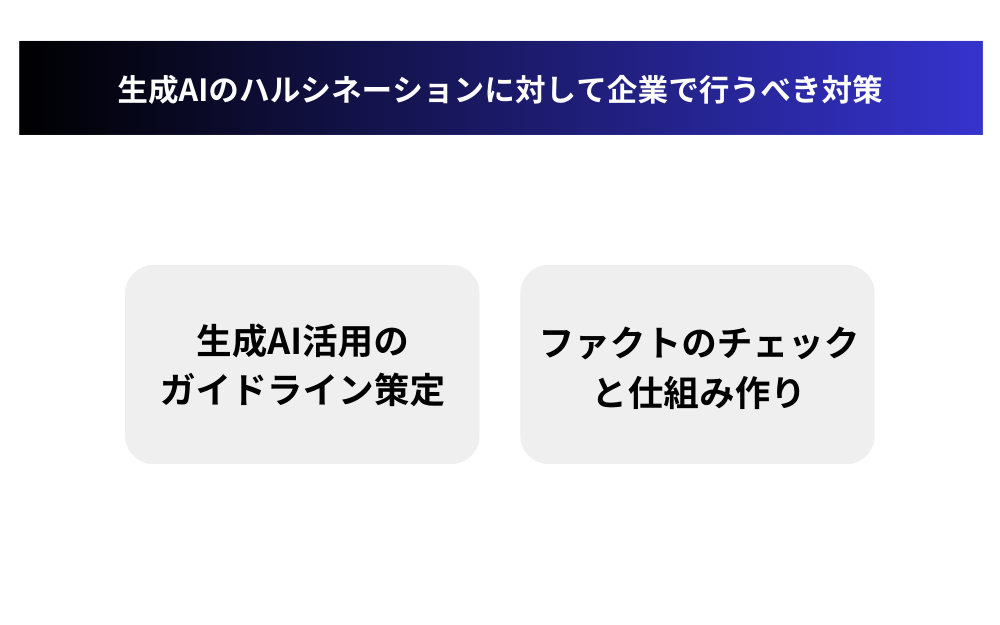

生成AIのハルシネーションに対して企業で行うべき対策

企業全体で生成AIを安全に活用するためには、組織的な取り組みが不可欠です。特にハルシネーションのリスク管理については、体系的な対策の実施が求められます。

生成AI活用のガイドライン策定

企業全体での生成AI活用を安全に進めるためには、明確なガイドラインの策定が重要です。このガイドラインには、生成AIの使用可能な範囲、禁止事項、確認プロセスなどを具体的に定める必要があります。例えば、外部公開文書の作成では必ず人間による確認を行うこと、重要な意思決定には生成AIの出力のみを根拠としないことなどを明記します。また、プロンプトの作成基準や、出力結果の検証方法についても具体的な指針を示すことが重要です。

さらに、各部門や業務の特性に応じた利用ガイドラインも必要です。たとえば、法務部門では法的文書の作成における注意点、マーケティング部門では広告コピーの作成における確認プロセスなど、部門固有の要件を反映させることで、より実効性の高いガイドラインとなります。

ファクトのチェックと仕組み作り

生成AIの出力内容を確実に検証するための仕組み作りも重要です。まず、社内での検証プロセスを確立する必要があります。これには、チェックリストの作成、複数人によるレビュー体制の構築、専門家による最終確認など、重層的な確認の仕組みが含まれます。また、検証に必要な参照情報へのアクセス手段も整備する必要があります。

特に重要なのは、検証作業を効率的に行える環境の整備です。たとえば、よく参照される情報のデータベース化、検証結果の記録と共有の仕組み、検証プロセスの自動化ツールの導入などが考えられます。これらの仕組みを整備することで、検証作業の質を保ちながら、業務効率を維持することが可能になります。

また、検証結果のフィードバックループを構築することも重要です。発見されたハルシネーションの事例や、効果的な検証方法について、組織内で知見を共有し、継続的な改善につなげることができます。このような学習の仕組みを通じて、組織全体のリスク管理能力を高めることができます。

まとめ:生成AIのハルシネーション対策を行い、正しく生成AIを活用しよう

生成AIのハルシネーションは完全な防止が難しい課題ですが、適切な対策により、そのリスクを大幅に低減することが可能です。プロンプトの工夫や複数回の検証、Chain-of-Thoughtの活用、RAGの導入など、基本的な対策と応用的な対策を組み合わせることで、より安全な活用が実現できます。

企業での活用においては、明確なガイドラインの策定とファクトチェックの仕組み作りが重要です。また、ハルシネーション発生時の対応手順を確立し、組織全体で共有することも必要です。

これらの対策を適切に実施することで、生成AIの持つ可能性を最大限に引き出しながら、リスクを最小限に抑えた活用が可能になります。

生成AIの活用にお困りではないですか?

株式会社アドカルは主に生成AIを活用したマーケティングDXや業務効率化に強みを持った企業です。

貴社のパートナーとして、少数精鋭で担当させていただくので、

「生成AIをマーケティング業務に活用したい」

「業務効率を改善したい」

「自社の業務に生成AIを取り入れたい」

とお悩みの方は、ぜひ弊社にご相談ください。

貴社のご相談内容に合わせて、最適なご提案をさせていただきます。

サービスの詳細は下記からご確認ください。