ChatGPT APIの料金は?モデル比較・計算方法・目安を解説

この記事でわかること

- ChatGPT API 料金とおすすめのプラン

- ChatGPT APIのモデル種類とそれぞれの料金や特徴

- ChatGPT API料金の計算方法や目安

ChatGPT APIを活用してビジネスやサービスを強化したいと考えていますか?

最大の懸念点は「料金がいくらかかるのか」という点でしょう。

本記事では、ChatGPT APIの料金体系をモデル別に徹底比較し、トークン単価から実際の計算方法まで詳しく解説します。

さらに、APIコストを削減できる実践的な6つの方法も紹介します。

適切なモデル選択や使い方の工夫で、AIの力を予算内で最大限に活用する方法を学びましょう。

目次

ChatGPT API 料金の基本的な仕組みと特徴

※引用:https://openai.com/ja-JP/api/

ChatGPT APIを効果的に活用するためには、その料金体系を正確に理解することが不可欠です。

ここでは、ChatGPT APIの基本概念から課金の仕組み、特徴までを解説します。

ChatGPT APIとは何か:機能と活用方法

ChatGPT APIは、OpenAI社が提供するプログラミングインターフェースで、ChatGPTの機能を外部システムに組み込んで利用できるサービスです。

2023年3月にリリースされ、ブラウザ上でしか使えなかったChatGPTの機能を、自社のアプリケーションやWebサービスに統合することが可能になりました。

APIを活用することで、顧客からの質問に自動で応答するシステムや、文章作成・要約・添削ツール、多言語翻訳システム、情報検索システムなどを構築できます。

特にコンタクトセンター業務では、問い合わせ対応の自動化や社内マニュアルの作成支援など、業務効率化に大きく貢献します。

ChatGPT APIは、推論モデルと非推論モデルが提供されており、用途や予算に応じて選択することができます。

それぞれのモデルには特徴があり、適切なモデル選択が効率的なAPI利用の第一歩となります。

トークンとは何か:APIにおける課金単位の理解

ChatGPT APIにおける「トークン」とは、テキストを小さな単位に分けたもので、料金計算の基本単位となります。

トークンは単純な文字数ではなく、言語処理の観点からテキストを分割した単位です。

トークンの特徴を簡潔にまとめると以下のようになります。

・単語単位:英語では一般的に1単語が約1トークン

・記号も対象:句読点や記号もトークンとしてカウント

・言語による差:日本語は1文字あたり1トークン以上が一般的

・漢字の複雑性:日本語の漢字は1文字で2〜3トークンを消費することも

例えば、英語の「Hello World!」は2〜3トークン程度ですが、日本語の「こんにちは世界!」は「こ・ん・に・ち・は・世・界・!」と分解され、さらに漢字は複数トークンとしてカウントされるため、全体で10トークン前後になることもあります。

このトークン数の違いが、後述する料金計算や最適な言語選択に大きく影響するため、正確な理解が重要です。

入力と出力で異なる料金体系

ChatGPT APIの料金体系の大きな特徴は、入力(ユーザーがAPIに送信するテキスト)と出力(APIが生成するテキスト)で異なる料金が設定されていることです。

一般的に、出力トークンの方が入力トークンよりも高い料金設定となっています。

この理由は、出力の生成がより計算資源を必要とするためです。

例えば、GPT-4.1モデルの場合、入力は1Mトークンあたり2ドル、出力は1Mトークンあたり8ドルという料金設定になっています。

この料金差を理解することで、特に出力トークン数を意識したプロンプト設計が重要になります。

質問や指示を工夫することで、必要最小限の出力で目的を達成できれば、コスト効率を大幅に向上させることができます。

従量課金制の仕組みとメリット

ChatGPT APIは完全な従量課金制を採用しており、使用したトークン数に応じて料金が発生します。

この仕組みは以下の計算式で表されます。

(入力トークン数 ÷ 1000) × 入力トークン料金 + (出力トークン数 ÷ 1000) × 出力トークン料金 = 利用料金

サブスクリプション型のChatGPTのブラウザ版(月額固定料金)とは異なり、APIは使った分だけ支払う形式です。

この従量課金制には以下のようなメリットがあります。

・柔軟性:使用量に応じて料金が変動するため、小規模な利用から始められる

・コスト効率:使用しない時間帯の固定費がかからない

・スケーラビリティ:ビジネス成長に合わせて段階的に拡張可能

・透明性:使用量と料金の関係が明確で予算管理がしやすい

特に開発初期やテスト段階では、従量課金制により低コストでAPIの機能を検証できるため、新規プロジェクトの立ち上げに適しています。

ただし、使用量が増えると予想外の高額請求になる可能性もあるため、後述する利用上限の設定なども重要です。

ChatGPT API モデル別の料金や特徴を比較

ここではChatGPTのAPIの各モデル別の特徴や料金について解説します。以下に、ChatGPT APIの主要モデルの料金体系と特徴を表形式にまとめました。

※最新情報については必ずOpenAIの公式サイトのAPI料金ページも合わせて確認しましょう。

| モデル | 入力料金(100万トークン) | キャッシュされた入力 | 出力料金(100万トークン) | 特徴・用途 | コンテキスト長 |

|---|---|---|---|---|---|

| 最新リーズニングモデル | |||||

| OpenAI o1 | $10.00 | $2.50 | $40.00 | 複雑な思考問題、STEM分野に最適。推論トークンで段階的思考が可能 | 200K |

| OpenAI o3-mini | $1.10 | $0.275 | $4.40 | o1より24%高速、コスト効率に優れた推論モデル。STEM分野で高性能 | 200K |

| 日常的タスク向けGPTモデル | |||||

| GPT-4.1 | $2.00 | $0.50 | $8.00 | コーディング・指示追従性に優れた最高性能モデル | 1M |

| GPT-4.1 mini | $0.40 | $0.10 | $1.60 | バランス型。GPT-4oに匹敵する性能でレイテンシ半減 | 1M |

| GPT-4.1 nano | $0.10 | $0.025 | $0.40 | 最速・最安値モデル。日常タスクに最適 | 1M |

| RealtimeAPI | |||||

| GPT-4o(テキスト) | $5.00 | $2.50 | $20.00 | 低レイテンシのマルチモーダル体験構築向け | – |

| GPT-4o(音声) | $40.00 | $2.50 | $80.00 | リアルタイム音声会話向け(約$0.5/3分) | – |

| GPT-4o mini(テキスト) | $0.60 | $0.30 | $2.40 | 低コストでのマルチモーダル体験構築向け | – |

| GPT-4o mini(音声) | $10.00 | $0.30 | $20.00 | 低コストのリアルタイム音声会話向け | – |

| Image Generation API | |||||

| GPT-image-1(テキスト) | $5.00 | – | – | DALL-E 3によるテキストからの画像生成 | – |

| GPT-image-1(画像) | $10.00 | – | $40.00 | 品質・サイズ指定可能。正方形画像:低$0.01/中$0.04/高$0.17 | – |

推論型モデルの料金と特徴|o1、o3-mini

| モデル | 入力料金 | キャッシュされた入力 | 出力料金 |

|---|---|---|---|

| OpenAI o1 | $10.00 / 100万トークン | $2.50 / 100万トークン | $40.00 / 100万トークン |

| OpenAI o3-mini | $1.100 / 100万トークン | $0.275 / 100万トークン | $4.400 / 100万トークン |

推論型モデルは複雑な問題解決能力に特化したOpenAIの最新モデルです。o1はOpenAIの「推論に特化した最高峰モデル」として位置づけられ、STEM分野(科学・技術・工学・数学)で優れた性能を発揮します。特に数学ベンチマークや科学問題解決で高い精度を達成し、複雑なクエリに対して詳細かつ思慮深い回答を生成します。

一方、o3-miniはo1の進化版で、「より小さく、より速く、そしてより安価な推論モデル」として開発されました。科学、数学、プログラミングなど論理的思考を必要とする分野で特に優れた能力を持ちます。料金面では、入力トークン100万で1.1ドル、キャッシュされた入力トークン100万で0.275ドル、出力トークン100万で4.40ドルと、高性能ながらコスト効率に優れています。

両モデルとも200Kのコンテキスト長に対応し、「reasoning_effort」パラメータによって推論の「深さ」をlow、medium、highの3段階で調整可能です。o3-miniはSTEM分野のベンチマークでo1-miniを上回る性能を示しながら、o1-miniより24%速い応答時間を実現しています。

下記の記事も合わせてご覧ください。

OpenAI o3(ChatGPT o3)とは?機能や使い方、料金、o1との違いを解説

非推論型モデルの料金と特徴|GPT-4.1シリーズ

| モデル | 入力料金 | キャッシュされた入力 | 出力料金 |

|---|---|---|---|

| GPT-4.1 | $2.00 / 100万トークン | $0.50 / 100万トークン | $8.00 / 100万トークン |

| GPT-4.1 mini | $0.40 / 100万トークン | $0.10 / 100万トークン | $1.60 / 100万トークン |

| GPT-4.1 nano | $0.100 / 100万トークン | $0.025 / 100万トークン | $0.400 / 100万トークン |

GPT-4.1シリーズは2025年4月に登場した最新の非推論型モデルで、特にプログラミング能力の向上、出力速度の改善、コスト効率の良さが特徴です。このシリーズは「GPT-4.1」「GPT-4.1 mini」「GPT-4.1 nano」の3種類で構成されており、用途や予算に応じて選択できます。

GPT-4.1の画期的な特徴はコンテキストウィンドウの飛躍的な拡大で、最大100万トークンものテキストを一度に処理できるようになりました。これは英語なら約80万文字、日本語なら約70万文字に相当する膨大な量です。

料金面では、GPT-4.1は入力2ドル/100万トークン、出力8ドル/100万トークンで、従来のGPT-4oより20%安く設定されています。GPT-4.1 miniとnanoはさらに低コストで、特にnanoは「OpenAI史上最速かつ最も安価なモデル」として、入力0.1ドル/100万トークン、出力0.4ドル/100万トークンという驚異的な料金設定です。

GPT-4.1シリーズは指示追従能力が大幅に向上し、コーディングタスクや長文コンテキスト処理において飛躍的な性能向上を実現しています。 WEEL 現時点では開発者向けAPI経由での提供のみですが、その実用性とコストパフォーマンスの高さから多くの開発者から注目を集めています。

下記の記事も合わせてご覧ください。

【ChatGPT】GPT-4.1とは?機能や使い方、料金、プロンプトのコツを解説

RealtimeAPI

【テキストの場合のAPI料金】

| モデル | 入力料金 | キャッシュされた入力 | 出力料金 |

|---|---|---|---|

| GPT-4o | $5.00 / 100万トークン | $2.50 / 100万トークン | $20.00 / 100万トークン |

| GPT-4o mini | $0.60 / 100万トークン | $0.30 / 100万トークン | $2.40 / 100万トークン |

【音声の場合のAPI料金】

| デル | 入力料金 | キャッシュされた入力 | 出力料金 |

|---|---|---|---|

| GPT-4o | $40.00 / 100万トークン | $2.50 / 100万トークン | $80.00 / 100万トークン |

| GPT-4o mini | $10.00 / 100万トークン | $0.30 / 100万トークン | $20.00 / 100万トークン |

RealtimeAPIは2024年10月にOpenAIから発表された新しいAPIサービスで、リアルタイムで低遅延なマルチモーダル会話体験をアプリケーションに組み込むことができます。特に音声入力と出力をリアルタイムにストリーミングすることで、より自然で遅延の少ない会話を実現します。

このAPIの大きな特徴は、ChatGPTの「Advanced Voice Mode」と同じく6つのプリセット音声を使用して自然なspeech-to-speechをサポートすることが可能です。従来の音声アシスタントでは、音声認識、テキスト処理、音声合成の3ステップが必要でしたが、RealtimeAPIではこれらが一体化されています。

料金体系は1分あたり、入力が0.06ドル、出力が0.24ドルに設定されており、一般的な3分程度のセッションでは約0.5ドル(約71円) になります。他のTTSモデルと比較するとやや高めですが、その品質と自然さは群を抜いています。

現在RealtimeAPIは音声をサポートしていますが、将来的にはVisionやVideoなどのモダリティも追加される予定です。 さらに、「GPT-4o mini」のサポートや「Prompt Caching」機能の追加も計画されており、今後より使いやすく進化していくことが期待されています。

Image Generation API

【テキストの場合のAPI料金】

| モデル | 入力料金 | 出力料金 |

|---|---|---|

| GPT-image-1 | $5.00 / 100万トークン | – |

【画像の場合のAPI料金】

| モデル | 入力料金 | 出力料金 |

|---|---|---|

| GPT-image-1 | $10.00 / 100万トークン | $40.00 / 100万トークン |

OpenAIのImage Generation APIは、AI画像生成技術DALL-E 3を外部アプリケーションから利用できるようにするサービスです。このAPIを使えば、サイズや画質などのパラメータを細かく指定でき、ウェブサイトやSNS、ブログ投稿など用途に適した画像生成が可能になります。

DALL-E 3はテキストプロンプトから高品質な画像を生成するOpenAIの画像生成AIで、従来のモデルより大幅に向上した理解力と生成品質を誇ります。 APIでは生成する画像のサイズ(1024×1024、1024×1792、1792×1024ピクセル)や画質(standard/HD)を指定できます。

料金については、テキスト入力が100万トークンあたり5.00ドル、画像入力が100万トークンあたり10.00ドル、出力が100万トークンあたり40.00ドルに設定されています。 出力画像の料金は品質とサイズによって変わり、正方形の画像の場合、低品質で約0.01ドル、中品質で約0.04ドル、高品質で約0.17ドルとなります。

生成された画像はコンテンツポリシーに従う限り商用利用も可能で、販売や商品化の権利も含めてユーザーに所有権があります。また、2024年2月からはDALL-E 3で生成された画像にメタデータが埋め込まれるようになり、AIによる生成物であることが明示されるようになりました。これにより透明性が高まり、フェイクニュース対策も強化されています。

モデル間の性能と料金の比較

OpenAIの各モデルは性能と料金のバランスに応じて最適な用途が異なります。推論型モデルのo1シリーズは複雑な問題解決や高度な思考を要するタスクに最適で、科学論文の要約や数学問題の解決などに威力を発揮します。特にo3-miniは高い推論能力を保ちながら応答速度と料金バランスに優れ、教育機関や中小規模プロジェクトに最適です。

一方、GPT-4.1シリーズは汎用性に優れ、特に長文脈処理と高速なレスポンスを両立しています。 GPT-4.1はフラッグシップモデルとして最高性能を誇り、GPT-4.1 miniはバランス型、GPT-4.1 nanoは最速・最安値モデルとして位置づけられています。

料金比較では、同等の処理量(100万トークン)でみると、推論型モデルは非推論型より高額です。o1は入力10ドル/出力40ドルに対し、GPT-4.1は入力2ドル/出力8ドルとなっています。小型モデル同士を比較すると、o3-miniは入力1.1ドル/出力4.4ドルに対し、GPT-4.1 nanoは入力0.1ドル/出力0.4ドルと約10分の1の料金です。

選定の際は、タスクの性質(日常的な処理か重要な意思決定か)、応答時間の要件(リアルタイム性が必要か精度優先か)、コンテキストの大きさ(処理する文書の量)を考慮すると良いでしょう。 高度な思考が必要なSTEM分野での活用にはo3-mini、大規模なコンテンツ処理やコーディングにはGPT-4.1、コスト重視の日常タスクにはGPT-4.1 nanoが適しています。

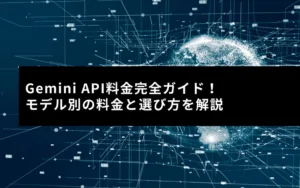

ChatGPT API 料金の計算方法と確認手順

ChatGPT APIを効率的に活用するためには、具体的な料金計算方法を理解し、使用量を適切に管理することが重要です。

このセクションでは、トークン数の計算方法から実際の料金計算例、そして使用量の確認方法までを解説します。

トークン数の計算方法と無料ツール

トークン数を正確に把握することは、API利用料金の予測に不可欠です。

トークン数を計算する最も簡単な方法は、OpenAIが提供している「Tokenizer」というオンラインツールを使用することです。

Tokenizerの使用手順は以下のとおりです。

・OpenAIのTokenizerサイト(Toknizer(OpenAI))にアクセス

・入力ボックスにトークン数を計算したい文章を入力 ・自動的にトークン数が算出される

このツールを使うと、文章のトークン数だけでなく、トークンがどのように分割されているかも確認できます。

日本語の場合は、表示が若干原文と異なることがありますが、おおよその目安として使用できます。

トークン数はプログラミング言語からも計算可能です。

Pythonを使用する場合は、OpenAIのライブラリを利用して計算できます。

ただし、初心者の方やプログラミングに不慣れな方は、まずはTokenizerツールの利用から始めることをおすすめします。

具体的な料金計算の例:英語と日本語の違い

ChatGPT APIの料金計算式は以下のようになります。

(入力トークン数 ÷ 1000) × 入力トークン料金 + (出力トークン数 ÷ 1000) × 出力トークン料金 = 利用料金

この計算において、言語による違いが大きく影響します。

同じ内容を伝える文章でも、日本語は英語に比べて約2〜3倍のトークンを消費する傾向があります。

これは日本語の漢字が特に多くのトークンを消費するためです。

この事実は、特に大量のテキスト処理を行う場合に重要な意味を持ちます。

使用量と請求額の確認方法

API利用状況や請求額を確認するには、OpenAIの開発者プラットフォームを使用します。

具体的な手順は以下のとおりです。

- OpenAIのAPI管理ページにログイン

- 左側のメニューから「Usage」を選択

- 当月の使用状況や請求額を確認できる画面が表示される

このページでは、モデルごとのトークン使用量や、日別・月別の使用状況をグラフで確認できます。

また、過去の請求履歴を参照したり、請求データをCSV形式でエクスポートすることも可能です。

定期的に使用状況を確認することで、予期せぬ高額請求を防ぎ、予算内で効率的にAPIを利用することができます。

特に商用利用や大規模なプロジェクトでは、この確認作業を習慣化することが重要です。

また、使用量の急増を防ぐために、OpenAI開発者プラットフォームの「Settings」→「Billing」から使用上限(Usage Limits)を設定することもできます。

この機能を活用すれば、予算を超える使用を自動的に制限することが可能です。

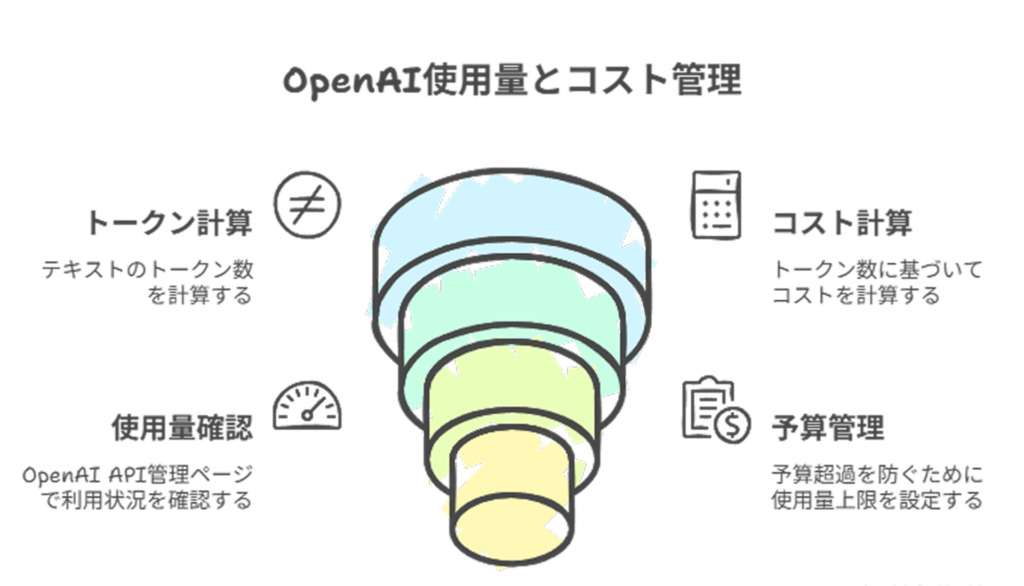

ChatGPT API 料金を削減する6つの方法

ChatGPT APIは従量課金制のため、賢く使用することで大幅なコスト削減が可能です。

ここでは、実践的な6つの方法を紹介します。

適切なモデルの選択でコスト効率を向上させる

最も効果的なコスト削減方法は、タスクに最適なモデルを選択することです。

高度な理解力や複雑な処理が必要でない場合、GPT-4.1 nanoで十分なケースが多くあります。

例えば、社内文書作成、シンプルなFAQ対応、基本的なカスタマーサポートなどのタスクであれば高い効果を発揮します。

また、開発初期のプロトタイプ段階では、コスト効率の良いGPT-4.1 nanoでテストし、必要に応じて段階的にGPT-4.1や推論型モデルへアップグレードするという戦略も効果的です。

必ずしも一つのモデルに固定する必要はなく、タスクの複雑さや重要度に応じて使い分けることで、全体的なコストバランスを最適化できます。

プロンプトの最適化でトークン消費を減らす

効率的なプロンプト(指示文)設計は、トークン消費量を大幅に削減します。

具体的かつ明確な指示を与えることで、AIの無駄な出力を減らし、必要な情報だけを得ることができます。

特に効果的なプロンプト最適化のポイントは以下のとおりです。

・出力形式の指定:「500文字以内で」「箇条書きで」など

・具体的な質問:漠然とした質問より具体的な質問の方が無駄が少ない

・段階的な指示:複雑なタスクは一度に指示するより段階的に指示する方が効率的

また、プロンプトの練習と改善を重ねることで、同じ結果を得るのに必要なトークン数を徐々に減らしていくことができます。

特に出力トークンは入力トークンより高額なため、出力量を制御することがコスト削減に直結します。

日本語と英語の使い分けでトークン効率を高める

言語選択もトークン消費量に大きく影響します。

同じ内容を伝える場合、日本語は英語と比較して約2〜3倍のトークンを消費することが一般的です。

特に漢字を多く含む文章では、この差がさらに広がります。

ただし、翻訳の手間やコストも考慮する必要があるため、処理するテキスト量や用途に応じて判断することが重要です。

特に大規模なデータ処理や継続的な利用では、この方法による削減効果は大きくなります。

会話履歴の管理で無駄なトークン消費を避ける

ChatGPT APIを会話形式で利用する場合、過去のやり取りを文脈として参照するためにもトークンを消費します。

特に長時間の会話になると、この履歴のトークン消費量は膨大になる可能性があります。

効率的な会話履歴管理のポイントは以下のとおりです。

・履歴の制限:全ての履歴ではなく、2〜3回前までの会話に限定する

・重要な情報の要約:長い会話履歴を要約して引き継ぐ

・不要な情報の削除:挨拶や冗長な表現など、文脈理解に不要な部分を省略

履歴を完全に無視すると文脈に沿った応答ができなくなるため、バランスが重要です。

適切な履歴管理によって、文脈の理解を維持しながら、トークン消費を30%以上削減できるケースもあります。

トークン上限の設定で予期せぬ高額請求を防ぐ

APIの利用が増えると、予期せぬ高額請求が発生するリスクがあります。

これを防ぐために、OpenAIの開発者プラットフォームでは使用上限を設定できる機能が提供されています。

設定手順は簡単です。

- OpenAI開発者プラットフォームにログイン

- 左側メニューの「Settings」を選択

- 「Billing」をクリック

- 「Usage Limits」で月額の上限金額を設定

この設定により、指定した金額に達すると自動的にAPIの利用が停止されます。

上限に達した場合でも後から変更可能なので、初期段階では控えめな金額を設定し、必要に応じて調整することをおすすめします。

これは単純ですが最も確実な保険策であり、特に複数人でAPIキーを共有している場合や、自動化されたシステムでの利用時には重要な設定です。

無料枠を最大限活用する方法

2024年4月現在、ChatGPT APIに新規登録したユーザーには5ドル分の無料クレジットが付与され、その有効期限は3か月となっています。

これは約250万トークンに相当するため、小規模な実験やテストには十分な量です。

この無料枠を効果的に活用するポイントは以下のとおりです。

・各モデルの性能比較:本格導入前に異なるモデルを試す

・プロンプト設計の実験:最適なプロンプトパターンを発見する

・トークン消費量の把握:実際の用途でどれだけのトークンが消費されるか測定

以前は18ドルの無料枠が提供されていましたが、現在は5ドルに減額されています。

しかし、上記の方法を組み合わせれば、この無料枠でも十分な実験やテストが可能です。

無料期間が終了する前に、コスト効率の良いAPI利用方法を確立しておくことで、有料移行後もスムーズかつ経済的な運用が実現できます。

ChatGPT API 料金対効果で選ぶベストなモデル

最適なChatGPT APIモデルの選択は、コストと性能のバランスを考慮した重要な意思決定です。

ここでは、タスクの複雑さや用途に応じた最適なモデル選択の指針を提供します。

シンプルなタスクに最適なモデルとその費用対効果

シンプルで基本的なAI機能を求めるケースでは、GPT-4.1 nanoが圧倒的なコストパフォーマンスを発揮します。 入力が100万トークンあたり0.1ドル、出力が0.4ドルという料金設定は、最高性能モデルの約20分の1というコスト効率の良さを実現しています。

GPT-4.1 nanoが特に効果的なユースケースは以下のとおりです:

- 基本的な社内文書作成:報告書、議事録、メールのドラフトなど

- 標準的なFAQ対応:一般的な質問に答えるチャットボット

- テキスト要約:ニュース記事やレポートの要約

- シンプルなコード生成:基本的なプログラミングタスク

また、GPT-4.1 nanoはOpenAI史上最速のモデルとして、リアルタイム性が重視されるアプリケーションにも最適です。 ライブチャットサポートや即時応答が必要なカスタマーサービスツールでは、この高速性が大きなメリットとなります。

GPT-4.1 miniは、nanoよりやや高価ですが、より複雑なタスクにも対応できるバランス型モデルです。入力0.4ドル/出力1.6ドルという価格で、GPT-4oに匹敵する性能とレイテンシ半減を実現しています。

複雑なタスクに求められるモデルの選び方

高度な理解力や精度が求められる複雑なタスクでは、フラッグシップモデルのGPT-4.1または推論型モデルのo3-miniが有効です。

GPT-4.1は入力2ドル/出力8ドルと高めの料金設定ですが、コーディング能力と指示追従性に優れ、複雑なタスクでも高い精度を発揮します。特に100万トークンというコンテキストウィンドウの大きさが最大の強みです。これにより、長文の分析や複数の文書を一度に処理することが可能になります。

GPT-4.1が特に効果的なケースは以下のとおりです:

- 専門的な文書作成:法律文書、技術マニュアル、医療レポートなど

- 複雑な質問応答:多段階の推論や深い理解が必要な質問

- 高精度な分析:データの微妙なパターンや傾向の分析

- 創造的なコンテンツ生成:高品質な記事、マーケティングコピー

STEM分野(科学・技術・工学・数学)の専門的なタスクでは、o3-miniが最適です。入力1.1ドル/出力4.4ドルと、GPT-4.1より安価ながら、推論能力に優れており、数学問題解決や科学論文分析などで高い性能を発揮します。

商用利用時の料金と注意点

ChatGPT APIは商用利用が可能ですが、いくつかの重要な注意点があります。

まず、料金は完全な従量課金制のため、利用が増加するほど料金も比例して増加します。

そのため、事前の利用見込み量の試算と予算設定が不可欠です。

商用利用時の主な注意点は以下のとおりです。

・命名規則の制限:「○○GPT」のような名称の使用は禁止されています

・ブランディング制限:OpenAIのロゴや商標の不適切な使用は避ける

・利用条件の確認:定期的に更新されるOpenAIの利用規約を確認する

また、商用サービスを提供する場合は、APIの停止やモデルの変更、料金体系の改定などのリスクも考慮に入れる必要があります。

特に重要なビジネスプロセスに組み込む場合は、代替手段の検討やコンティンジェンシープランの作成も重要です。

なお、コンテンツ生成においては著作権やプライバシーに関する配慮も必要です。

生成されたコンテンツの責任は最終的に利用者側にあることを認識しておきましょう。

ユースケース別コストパフォーマンス分析

具体的なユースケース別にどのモデルが最適かを分析すると、以下のような指針が見えてきます。

| 分野 | 用途 | 推奨モデル | 特徴 |

|---|---|---|---|

| カスタマーサポート | 一般的な問い合わせ対応 | GPT-4.1 nano | コスト効率◎、応答速度◎ |

| 複雑な技術サポート | GPT-4.1 | 理解度◎、解決精度◎ | |

| ハイブリッドアプローチ | nano → GPT-4.1 | コスト最適化(簡単な質問はnano、難しい質問は4.1) | |

| コンテンツ生成 | 大量の基本的な記事 | GPT-4.1 mini | コスト効率◎、スケーラビリティ◎ |

| 高品質な専門コンテンツ | GPT-4.1 | 品質◎、専門性◎ | |

| STEM関連専門分析 | o3-mini | 推論能力◎、科学精度◎ | |

| データ分析・処理 | 基本的なデータ要約 | GPT-4.1 nano | コスト効率◎、基本機能◎ |

| 大量のテキストデータ分析 | GPT-4.1 | 大容量処理◎、深い分析◎ | |

| 複雑なパターン認識 | o3-mini | 高度な推論◎、精度◎ | |

| 開発・テスト | プロトタイプ段階 | GPT-4.1 nano | コスト効率◎、迅速な開発◎ |

| 本番環境 | 目的に応じた使い分け | 重要・複雑なタスクはGPT-4.1 | |

| 音声対話アプリ | RealtimeAPI | 自然な対話◎、低遅延◎ | |

| 画像生成サービス | Image Generation API | 高品質画像◎、カスタマイズ性◎ |

結論として、絶対的に「最適」なモデルはなく、具体的なユースケース、予算制約、求められる品質・精度のバランスに応じて選択すべきです。

多くの場合、複数のモデルを目的に応じて使い分ける「ハイブリッドアプローチ」が最も費用対効果に優れた選択となります。

まとめ:ChatGPT API 料金を賢く抑えて効果的に活用しよう

ChatGPT APIは強力なAI機能を提供する一方で、その料金体系を理解し最適化することで、大幅なコスト削減が可能です。

トークンという独自の課金単位を正しく理解し、入出力それぞれの料金差を意識することが第一歩となります。

特に日本語は英語の2〜3倍のトークンを消費するため、大量処理では言語選択も重要です。

タスクの複雑さに応じたモデル選択も行いましょう。

プロンプトの最適化、会話履歴の管理、トークン上限の設定といった工夫を重ねることで、同じ予算でより多くの価値を引き出せます。

最終的には、シンプルなタスクと複雑なタスクでモデルを使い分ける「ハイブリッドアプローチ」が、コストパフォーマンスを最大化する鍵となります。

継続的な使用状況のモニタリングと最適化を通じて、ChatGPT APIを賢く活用していきましょう。

【生成AI活用でお困りではないですか?】

株式会社アドカルは主に生成AIを活用したマーケティングDXや業務効率化に強みを持った企業です。

貴社のパートナーとして、少数精鋭で担当させていただくので、

「生成AIを業務に活用したい」

「業務効率を改善したい」

「自社の業務に生成AIを取り入れたい」

とお悩みの方は、ぜひ弊社にご相談ください。

貴社のご相談内容に合わせて、最適なご提案をさせていただきます。

サービスの詳細は下記からご確認ください。無料相談も可能です。