なぜ生成AIの情報漏洩は起こるのか?事例や有効な対策を詳しく紹介!

この記事でわかること

- 生成AIで起こり得る情報漏洩のリスクとは

- 個人情報や機密情報が漏洩した具体的な事例

- 情報漏洩が発生する主な要因と仕組み

- 情報漏洩を防ぐための効果的な対策方法

生成AIの利用が広がる中、情報漏洩のリスクが大きな課題となっています。個人情報や機密情報が外部に流出する危険性から、企業は生成AIの導入に二の足を踏むケースも少なくありません。本記事では、生成AIにおける情報漏洩の原因と、その対策について詳しく解説します。

目次

生成AIの情報漏洩に関するリスクを徹底解説

生成AIが様々な分野で活用されるようになった一方で、情報漏洩のリスクが大きな課題となっています。特に懸念されるのが、個人情報や機密情報の漏洩です。生成AIに学習させるデータの中に、こうした重要な情報が含まれていると、思わぬ形で外部に流出してしまう恐れがあります。

個人情報・機密情報の漏洩のリスク

生成AIを利用する際に最も注意すべきなのが、個人情報や機密情報の取り扱いです。アバターの作成や議事録の自動生成など、生成AIの活用シーンは多岐にわたります。しかし、そのどれもが情報漏洩のリスクを内包しているのです。

例えば、アバター作成に生成AIを用いる場合、ユーザーの氏名や顔写真などの個人情報を入力する必要があります。しかし、その情報がAIの学習データとして利用され、意図せず第三者のアバターに反映されてしまう可能性があります。また、会議の議事録を自動生成する際も、参加者の発言内容に個人情報や機密情報が含まれていれば、同様の問題が起こり得ます。

こうしたリスクを防ぐには、生成AIに入力するデータを厳選することが大切です。個人情報や機密情報を含むデータは、できる限りAIに学習させないようにしましょう。どうしても必要な場合は、データを匿名化するなど、漏洩対策を十分に行ってください。また、生成AIから出力されたコンテンツを公開する前に、人の目でチェックする体制を整えることも重要です。

情報漏洩のリスクを軽視せず、細心の注意を払って生成AIに接することが求められます。リスクを正しく理解し、適切に対処することで、生成AIの恩恵を安全に享受できるはずです。

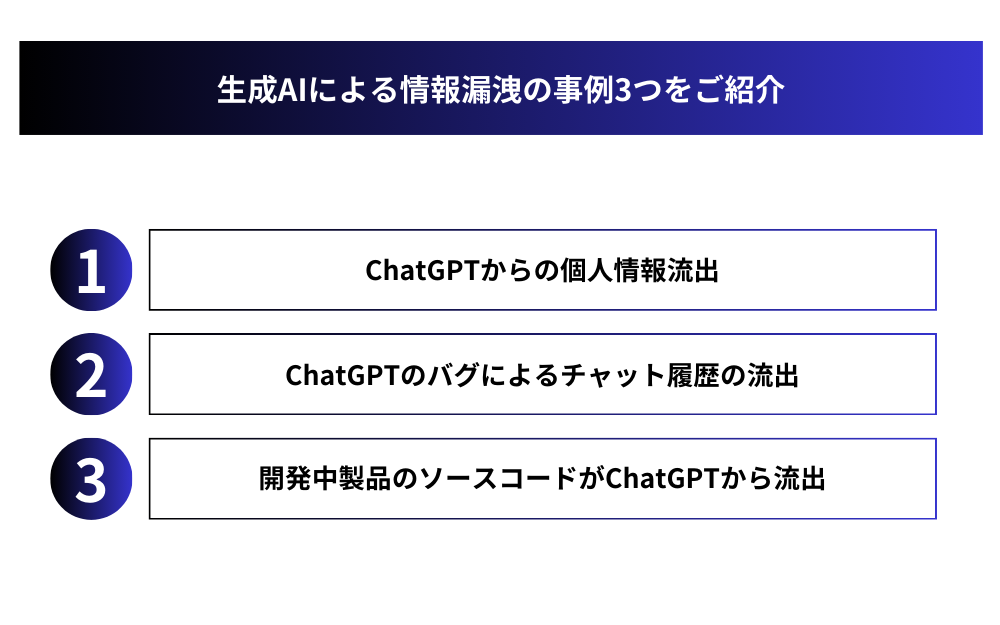

生成AIによる情報漏洩の事例3つをご紹介

生成AIの普及に伴い、これまでにいくつかの情報漏洩事例が報告されています。ここでは、個人情報や企業の機密情報が流出した代表的な事例を見ていきましょう。

事例1:ChatGPTからの個人情報流出(OpenAI社)

2023年3月、ChatGPTの開発元であるOpenAI社は、有料プラン「ChatGPT Plus」の契約ユーザーの個人情報が漏洩したことを公表しました。ユーザーの氏名、メールアドレス、クレジットカード情報などが、約10時間にわたって第三者に閲覧可能な状態になっていたのです。

原因はオープンソースライブラリーのバグにあったとされていますが、ChatGPTに限らず、生成AIサービスが個人情報漏洩の脅威にさらされていることを示唆する事例と言えるでしょう。利用者の立場からすれば、サービス提供側のセキュリティ対策も重要ですが、AIに入力する情報は慎重に選ぶ必要があります。

事例2:ChatGPTのバグによるチャット履歴の流出(OpenAI社)

こちらも2023年に発覚した事例です。ChatGPTの不具合により、ある利用者が過去に入力した質問と回答の履歴が、無関係の利用者の画面上に表示されてしまうという事態が起きました。履歴には、利用者が機密情報を含むプロンプトを入力していた場合、その内容も含まれていた可能性があります。

OpenAI社は、原因がインメモリ型データベースシステムのバグにあったと説明しています。バグ自体は数時間で修正されましたが、機密性の高い情報をChatGPTに入力していた企業にとっては、他者に閲覧される危険性があったことを意味します。生成AIを業務で活用する際は、利用ルールを設けるなど、慎重な運用が求められます。

事例3:開発中製品のソースコードがChatGPTから流出(大手電機メーカー)

ある大手電機メーカーの従業員が、開発中のソフトウェアのバグ修正をChatGPTに依頼したことで、ソースコードが外部に漏洩するという事件が起きました。生成AIは、利用者のプロンプトをAIの学習データとしても活用する仕組みです。そのため、機密情報を含むプロンプトを使うと、その情報が他のユーザーへの回答に反映されてしまう恐れがあります。

この事例は、従業員の機密情報に対する意識の低さに加えて、社内における生成AIの利用ルールが整備されていなかったことが背景にあると考えられます。生成AIに関する正しい理解を従業員間で共有し、利用時のガイドラインを設けることが肝要だと言えるでしょう。

以上の事例から、生成AIのセキュリティ面での課題と、利用者側に求められる対策が浮き彫りになります。便利なツールである一方で、情報漏洩のリスクは常につきまといます。企業は生成AIの特性を正しく理解した上で、適切な利用環境を整えていく必要があるのです。

生成AIで情報漏洩が発生する要因3つ

生成AIを利用する中で情報漏洩が起こるのは、主に以下の3つの要因が考えられます。AIの学習方法、インターネット上のデータ保管、技術的なバグです。それぞれについて詳しく見ていきましょう。

1.個人情報や機密情報を学習してしまうため

生成AIは、大量のデータを学習することで、新たなコンテンツを生み出します。しかし、その学習の過程で、個人情報や機密情報が意図せず利用されてしまうリスクがあるのです。

例えば、ある企業が自社の営業データをAIに学習させたとします。その営業データの中に、顧客の個人情報や取引先との契約内容など、社外秘の情報が含まれていた場合、それらがAIに記憶されてしまいます。そして、AIが生成したコンテンツの中に、その情報が紛れ込んでしまう恐れがあるのです。

こうしたリスクを防ぐには、AIに入力するデータを慎重に選定することが大切です。個人情報や機密情報を含むデータは、可能な限りAIに与えないようにしましょう。どうしても必要な場合は、データを匿名化するなど、情報漏洩対策を講じることが求められます。

2.セキュリティ対策が不十分

多くの生成AIは、クラウドサービスとして提供されています。つまり、ユーザーがAIに入力したデータは、インターネット上のサーバーに保管されるのです。そのため、サービス提供者のセキュリティ対策が不十分だと、サイバー攻撃によってデータが流出してしまう危険性があります。

実際に、過去にはクラウドサービスから大量の個人情報が流出する事件が相次いで発生しました。生成AIのサービスも、同様の脅威にさらされていると考えるべきでしょう。データの保管方法や暗号化の仕組みなど、セキュリティ面での評価を十分に行った上で、信頼できるサービスを選ぶことが肝要です。

3.技術的なバグ

生成AIを開発・運用する過程では、技術的なバグが生じるリスクがつきものです。例えば、本来アクセスが制限されているはずのデータにアクセスできてしまったり、生成されたコンテンツにユーザーの入力情報が残ってしまったりする不具合が発生する可能性があります。

こうしたバグは、AIのアルゴリズムやプログラムの複雑さゆえに起こり得ます。バグを完全に防ぐことは難しいかもしれませんが、入念なテストを重ねることである程度は回避できるはずです。加えて、バグが発見された際の速やかな修正体制を整えておくことも大切です。

以上の3点は、生成AIで情報漏洩が起こる主な要因と言えます。これらの要因を踏まえ、適切な対策を講じることが、安全な生成AI活用のカギを握っているのです。

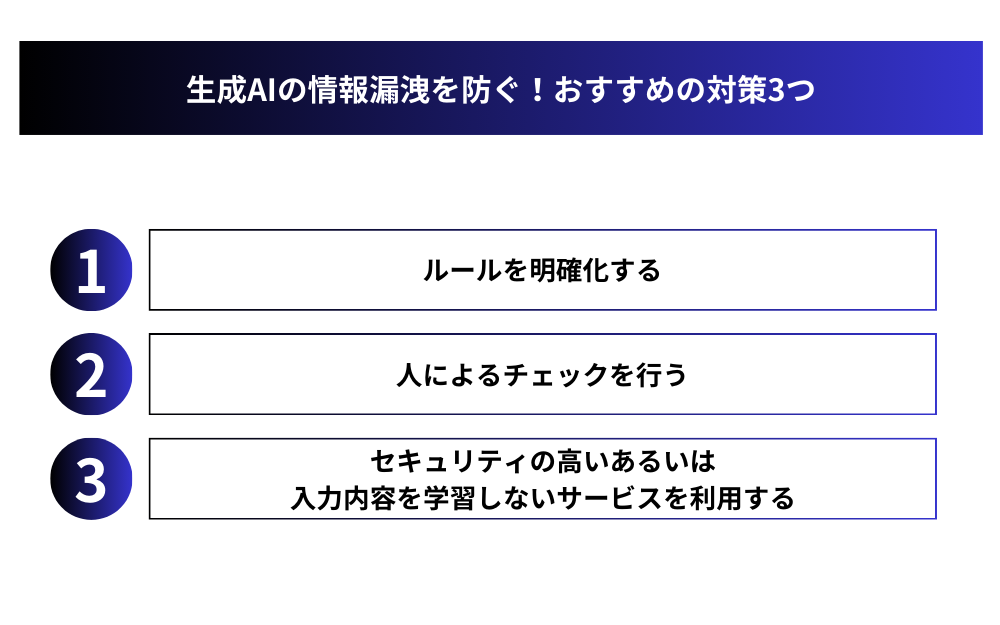

生成AIの情報漏洩を防ぐ!おすすめの対策3つ

生成AIを安全に活用するためには、情報漏洩のリスクに備えた対策が欠かせません。ここでは、特に有効な3つの方法を提案します。ルールの明確化、人によるチェック、セキュリティの高いサービスの利用です。

1.ルールを明確化する

生成AIを導入する際は、社内のルールを明確に定めることが重要です。具体的には、以下のような点を規定しておくとよいでしょう。

- AIに入力してはいけないデータの種類(個人情報、機密情報など)

- データを入力する際の anonymization など事前処理の方法

- AIの学習に用いるデータの保管・管理方法

- AIが生成したコンテンツの確認・承認プロセス

これらのルールを文章化し、関係者全員で共有することが大切です。ルールの内容は、定期的に見直しを行い、必要に応じてアップデートしていきましょう。ルールの徹底は、情報漏洩リスクの低減に直結するはずです。

2.人によるチェックを行う

AIが生成したコンテンツには、思わぬ形で個人情報や機密情報が紛れ込んでいる可能性があります。そのリスクを最小限に抑えるには、公開前に人の目でチェックする体制を整えることが有効です。

例えば、AIが生成した文章やイメージを、複数の担当者がレビューするプロセスを設けます。その際、機密保持の観点だけでなく、倫理面や法令遵守の視点からもチェックを行うことが求められます。人による確認を経ることで、情報漏洩のリスクを大幅に下げられるはずです。

3.セキュリティの高いあるいは入力内容を学習しないサービスを利用する

生成AIのサービスを選ぶ際は、セキュリティ面の評価を入念に行いましょう。特に、以下の点に注目すると良いでしょう。

- データの暗号化の仕組み

- 不正アクセス防止のためのセキュリティ対策

- 定期的なセキュリティ監査の実施状況

こうした観点から、客観的にセキュリティレベルの高いサービスを選ぶことが重要です。また、ユーザーの入力内容を学習しないタイプの生成AIサービスを利用するのも一つの選択肢です。入力データを保持せず、その場限りで処理するようなサービスであれば、情報漏洩のリスクを大幅に下げられます。

以上の3つの対策を組み合わせることで、生成AIの情報漏洩リスクを最小限に抑えることができるはずです。自社に合ったセキュリティ施策を講じ、安全に生成AIを活用していきましょう。

まとめ:生成AIは情報漏洩のリスクを抑えて利用しよう

生成AIは利便性が高い反面、情報漏洩のリスクが潜んでいます。リスクを理解した上で適切な対策を講じ、安全に活用することが何よりも大切です。社内ルールの整備、人によるチェック体制の確立、セキュリティの高いサービスの利用など、多角的なアプ

ローチで情報漏洩を防ぎましょう。生成AIの力を正しく活用することで、業務効率の向上とセキュリティの両立を実現できるはずです。

企業は生成AIの導入に二の足を踏むのではなく、適切な対策を講じた上で積極的に活用していくことが求められます。情報漏洩のリスクを過度に恐れるあまり、生成AIがもたらす大きなメリットを逃してはもったいないですからね。本記事を参考に、自社に合った情報漏洩対策を講じつつ、生成AIの力を存分に引き出していただければと思います。

【生成AI活用でお困りではないですか?】

株式会社アドカルは主に生成AIを活用したマーケティングDXや業務効率化に強みを持った企業です。

貴社のパートナーとして、少数精鋭で担当させていただくので、

「生成AIをマーケティング業務に活用したい」

「業務効率を改善したい」

「自社の業務に生成AIを取り入れたい」

とお悩みの方は、ぜひ弊社にご相談ください。

貴社のご相談内容に合わせて、最適なご提案をさせていただきます。

サービスの詳細は下記からご確認ください。無料相談も可能です。